- 🖼️ Atribución de imágenes

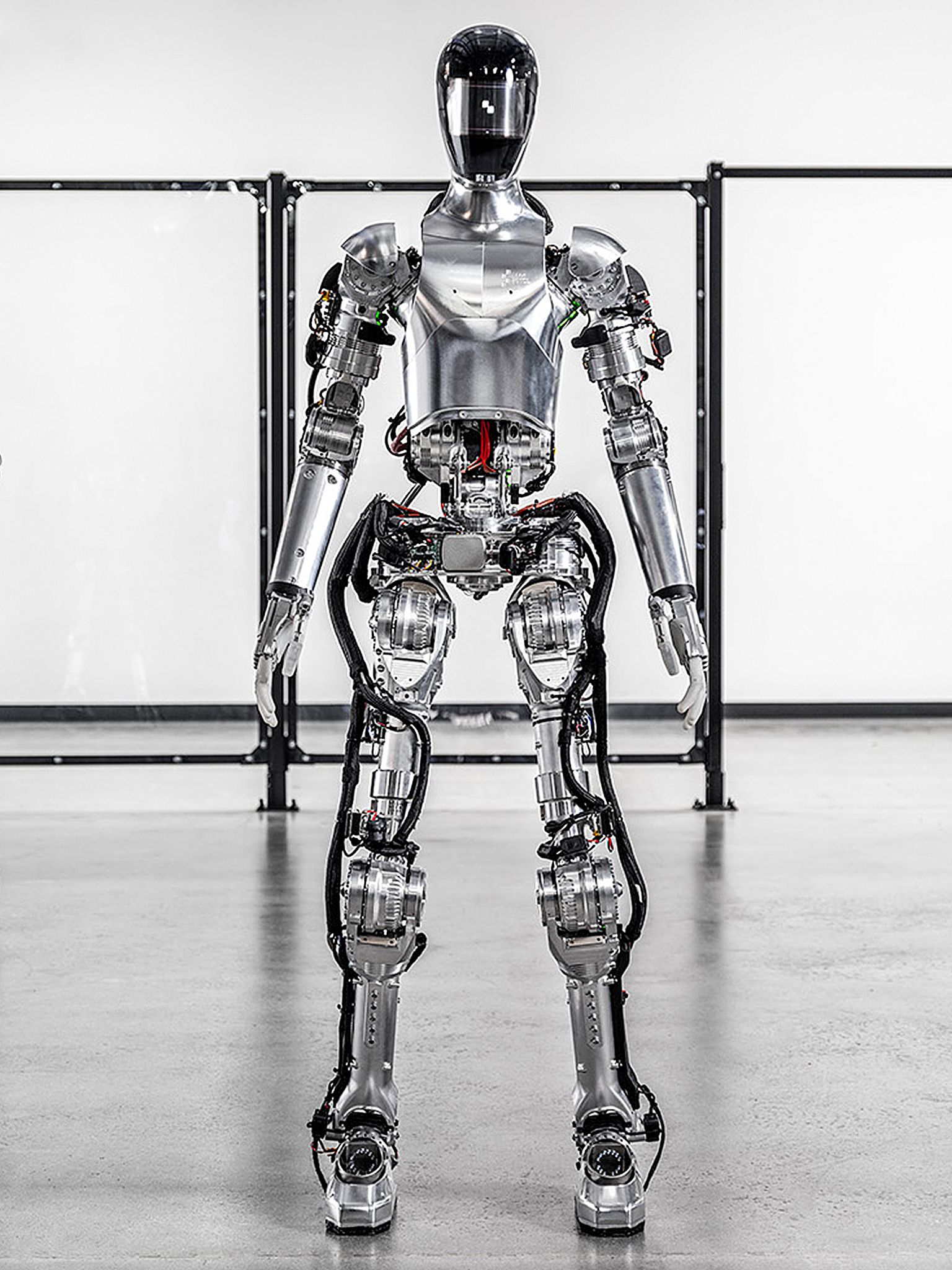

- 2.1 Figure 01 / Figure 03: el enfoque más avanzado en cognición

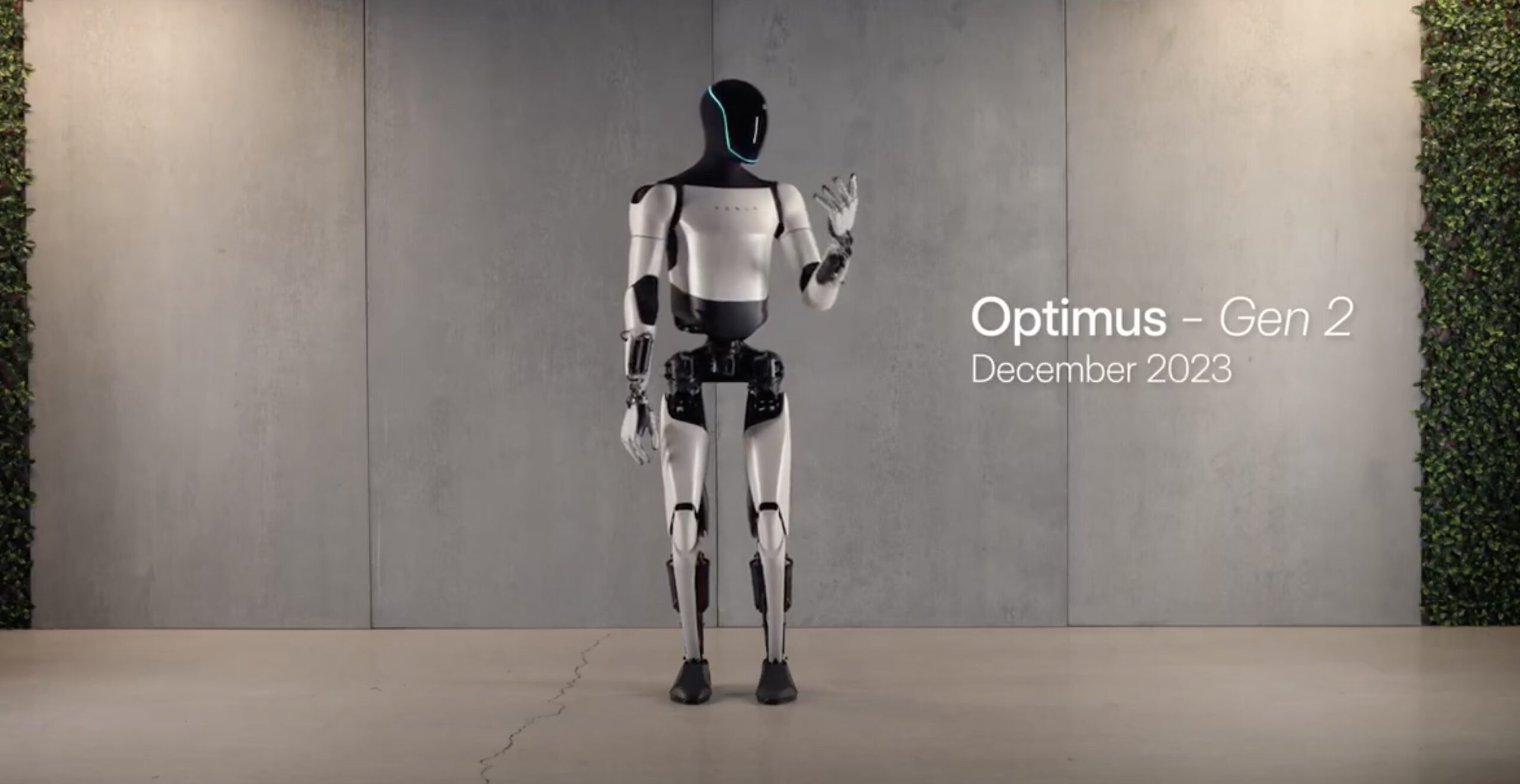

- 2.2 Tesla Optimus: el mejor sistema de actuadores del mercado

- 2.3 Unitree G1: el humanoide accesible que abre el mercado

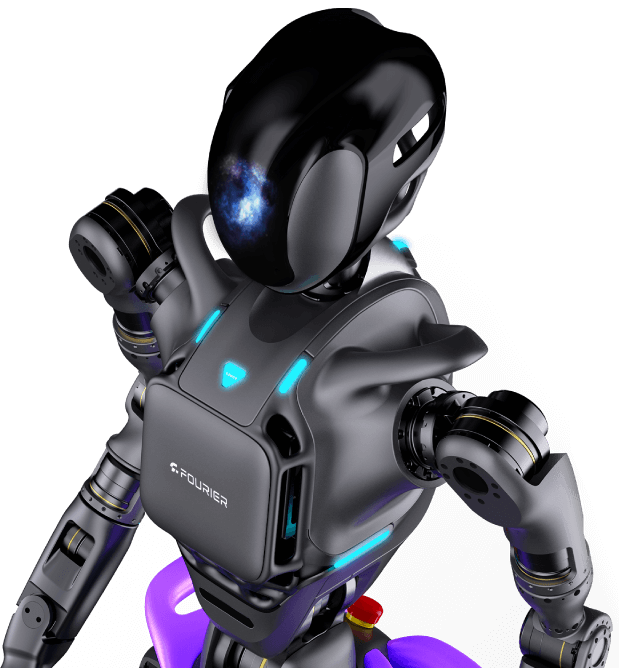

- 2.4 Fourier GR-1: la plataforma robusta para investigación

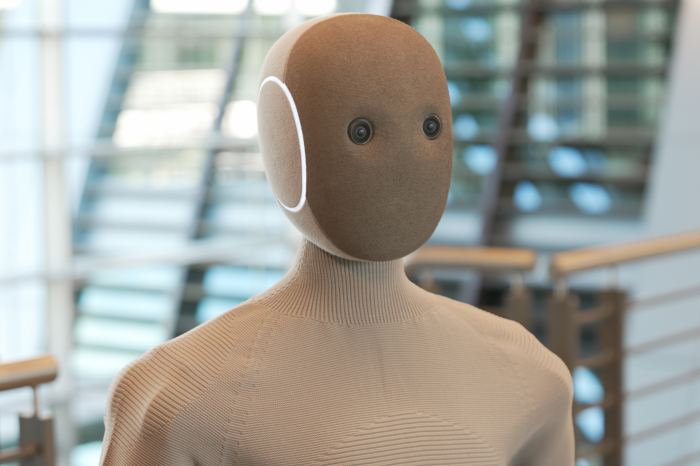

- 2.5 1X Neo: la teleoperación como puente hacia la autonomía

- Actuadores y locomoción

- Control, planificación y estabilidad

- Manipulación robótica

- Visión robótica y percepción

- IA multimodal y embodied AI

- Figure AI

- Tesla Optimus

- Unitree G1

- Fourier GR-1

- 1X Technologies (Neo y EVE)

- MIT Biomimetic Robotics Lab

- ETH Zürich – Robotic Systems Lab

- UC Berkeley – Robot Learning Lab

- Stanford Robotics & AI Lab

- Simulación y modelado

- Robotic Operating Systems

- Modelos de movilidad y control

- Fuentes de imágenes oficiales

🖼️ Atribución de imágenes

Las imágenes mostradas provienen de material oficial de prensa o demostraciones públicas de Figure AI, Tesla, Unitree Robotics, Fourier Intelligence y 1X Technologies.

1. Un punto de quiebre en la robótica humanoide

Los años 2025–2026 representan un periodo decisivo para la robótica humanoide. Por primera vez, varios robots con forma humana —antes confinados a laboratorios o ferias tecnológicas— comienzan a aparecer en catálogos comerciales y en planes de despliegue industrial real. Empresas como Figure AI, Tesla, Unitree, Fourier e 1X Technologies han demostrado locomoción estable, manipulación bimanual, percepción avanzada y una intención clara de preparar estos sistemas para contextos reales.

Este salto se sostiene sobre tres pilares: actuadores eficientes, IA multimodal y sensores de bajo costo y alta calidad. La combinación de estos elementos ha hecho posible que la fabricación de humanoides pase de ser un proyecto elitista a una industria emergente con economías de escala.

Sin embargo, es esencial distinguir entre lo que estos robots pueden realmente hacer hoy y lo que aún es proyección futura. La idea del “robot doméstico generalista” sigue siendo más aspiración que realidad. Este artículo analiza en profundidad las capacidades reales de los humanoides más relevantes del momento y los desafíos que aún impiden su uso cotidiano en hogares.

2. Los humanoides que definen el estándar 2025–2026

Estos modelos representan distintos enfoques y prioridades dentro del panorama humanoide moderno. Cada uno revela fortalezas, limitaciones y caminos tecnológicos únicos.

2.1 Figure 01 / Figure 03: el enfoque más avanzado en cognición

6

Figure AI es, probablemente, la empresa con el mayor avance cognitivo en humanoides. Sus demostraciones junto a OpenAI en 2024 mostraron un robot capaz de describir lo que ve, razonar sobre el entorno y planificar acciones usando modelos multimodales.

Su arquitectura combina actuadores eléctricos propietarios, manos antropomórficas con control de fuerza, visión estéreo, cámaras 360° y un sistema de aprendizaje por imitación altamente eficiente. El robot es capaz de aprender nuevas tareas a partir de unas pocas demostraciones humanas, una habilidad crítica para escenarios dinámicos.

No obstante, estas capacidades se han demostrado mayormente en entornos controlados. Figure 01 todavía no opera en hogares y depende de supervisión humana cuando la tarea se vuelve compleja o prolongada.

2.2 Tesla Optimus: el mejor sistema de actuadores del mercado

6

Tesla ha puesto su fuerza en el hardware. El robot Optimus Gen 2 usa actuadores de transmisión directa que ofrecen una relación peso–potencia excepcional, un elemento clave para manipulación fina y movimientos precisos. Además, hereda gran parte del stack de visión usado en la conducción autónoma de Tesla, un sistema entrenado con millones de casos reales.

Las demostraciones del robot incluyen doblado de ropa, verter líquidos, andar con control predictivo y movimientos de alta precisión. A nivel de ingeniería mecánica, Optimus es uno de los humanoides más avanzados del mundo.

Pero todavía no se ha mostrado evidencia de autonomía confiable en hogares. Muchas demostraciones son coreografiadas, y el robot no ha sido expuesto a entornos caóticos con múltiples variables no controladas.

2.3 Unitree G1: el humanoide accesible que abre el mercado

6

El Unitree G1 es el primer humanoide asequible para investigadores y desarrolladores. Con 23 grados de libertad y actuadores de bajo costo, apuesta por un equilibrio entre precio y funcionalidad. Su tamaño compacto lo vuelve ideal para experimentos seguros, demostraciones educativas y desarrollo de software.

El G1 puede caminar, abrir puertas, presionar interruptores, manipular objetos livianos y ejecutar tareas simple repetidas. Es una plataforma valiosa para avanzar en investigación aplicada.

Pero sus capacidades cognitivas son limitadas: no puede comprender escenas complejas, trabajar con objetos frágiles o deformables, ni resolver tareas domésticas bajo condiciones no estructuradas.

2.4 Fourier GR-1: la plataforma robusta para investigación

6

El Fourier GR-1 es un humanoide orientado a investigación académica, rehabilitación y experimentación con locomoción y manipulación. Su diseño robusto, más de 40 grados de libertad y compatibilidad con ROS 2 lo convierten en una herramienta útil para universidades y centros de desarrollo de robótica.

No está diseñado para el hogar. Carece del stack cognitivo necesario para operar en ambientes dinámicos y depende de usuarios expertos.

2.5 1X Neo: la teleoperación como puente hacia la autonomía

6

1X Neo destaca por su sofisticado sistema de teleoperación, uno de los mejores del mercado. Esta estrategia le permite ejecutar tareas domésticas complejas —pero solo porque un humano controla parte del proceso a distancia—. Neo sirve así como plataforma de transición: mientras se recopilan demostraciones humanas de alta calidad, la empresa desarrolla algoritmos para automatizar progresivamente esas tareas.

Aun así, no es un robot doméstico autónomo; su utilidad depende en gran medida de operadores humanos.

3. Más allá del marketing: lo que estos humanoides realmente pueden hacer

A pesar de que las demostraciones son llamativas, las capacidades reales deben evaluarse con cuidado. Todos estos robots son competentes en locomoción en superficies planas, cierto nivel de manipulación de objetos rígidos y tareas cortas que combinan visión y movimiento. La locomoción se ha beneficiado enormemente del uso de control predictivo (MPC) y control de impedancia, técnicas que hoy están estandarizadas.

La manipulación, en cambio, muestra grandes diferencias. Figure y Tesla lideran en control de fuerza y precisión, mientras que Unitree y Fourier se mantienen en niveles más básicos y orientados a investigación. Ningún humanoide actual muestra manipulación generalista o una capacidad robusta para interactuar con objetos deformables, irregulares o frágiles.

El gran obstáculo sigue siendo la autonomía cognitiva. Un hogar real es caótico, cambiante y lleno de incertidumbre. Los modelos multimodales actuales pueden razonar, pero aún cometen errores graves en tareas abiertas, en especial cuando la escena contiene múltiples objetos, o cuando el robot debe planear secuencias largas de acciones.

4. Hogares reales: el desafío supremo

Los humanoides actuales pueden realizar tareas útiles en entornos ordenados. Son competentes en transportar objetos, accionar interruptores, abrir puertas y clasificar elementos simples. Sin embargo, cuando se enfrentan a escenarios reales —pisos irregulares, iluminación variable, ruido visual, presencia de mascotas o niños— sus capacidades se reducen notablemente.

Las tareas domésticas requieren una combinación de destreza física, percepción avanzada y razonamiento profundo. Actividades aparentemente simples, como ordenar una habitación o limpiar una superficie sucia, son extremadamente difíciles para un robot debido a la enorme cantidad de decisiones pequeñas que exige cada acción.

Incluso demostraciones como doblar ropa, realizadas por Tesla, se vuelven problemáticas cuando se introducen múltiples tipos de tejidos o prendas deformables. En entornos domésticos, la variabilidad es la norma, no la excepción.

5. Los grandes obstáculos tecnológicos

Los tres grandes desafíos que limitan la autonomía doméstica son:

- Autonomía cognitiva insuficiente: Los robots aún no comprenden escenas complejas de forma fiable.

- Manipulación fina limitada: Los sensores táctiles y el control de fuerza están lejos del nivel humano.

- Robustez y seguridad: Un robot que opera cerca de personas debe ser extremadamente seguro ante caídas, golpes o errores de percepción.

A esto se suma la autonomía energética, generalmente de 1 a 3 horas, insuficiente para una jornada de trabajo doméstico.

6. Qué esperar entre 2026 y 2028

Es probable que veamos mejoras importantes en sensores táctiles, modelos multimodales especializados, algoritmos de planeamiento y robots más compactos diseñados específicamente para hogares. Algunos humanoides podrán ejecutar una o dos tareas domésticas completas con fiabilidad, pero aún no serán generalistas.

También veremos la aparición de ecosistemas de aplicaciones, algo así como “tiendas de apps” para robots, donde desarrolladores podrán programar tareas específicas para cada plataforma.

7. Conclusión

Los humanoides 2025–2026 marcan un antes y un después. La locomoción está madura, la manipulación mejora rápidamente y la IA multimodal ha abierto una puerta hacia el razonamiento contextual en robots. Sin embargo, aún estamos lejos del robot doméstico autónomo. La brecha entre un entorno controlado y un hogar real sigue siendo enorme.

Aun así, esta década será recordada como el inicio de la transición de robots que solo caminan a robots que realmente trabajan.

8. Referencias técnicas y académicas

Estos trabajos sustentan los fundamentos modernos en locomoción, control, actuadores, manipulación y percepción robótica.

Actuadores y locomoción

- Katz, B., et al. “Mini Cheetah: A Platform for Pushing the Limits of Dynamic Quadruped Control.” IEEE Robotics and Automation Letters, 2019–2023.

- Kim, S., et al. “Force-Controlled Actuation for Dynamic Locomotion.” MIT Biomimetic Robotics Lab, múltiples publicaciones 2015–2023.

- Hutter, M., et al. “Robust and Dynamic Legged Locomotion.” ETH Zürich Robotics Systems Lab, 2017–2024.

- Park, H.W., et al. “High Torque Density Actuator for Legged Robots.” IEEE RA-L, 2021.

Control, planificación y estabilidad

- Kuindersma, S., et al. “Optimization-based Locomotion Planning for the Atlas Humanoid Robot.” Autonomous Robots, 2016.

- Pontes-Filho, S., et al. “Whole Body Control for Torque-controlled Humanoid Robots.” IEEE ICRA, 2021.

- Wieber, P.-B. “Trajectory Free Linear Model Predictive Control for Stable Walking.” IEEE ICRA, 2006.

Manipulación robótica

- Levine, S., et al. “End-to-End Training of Deep Visuomotor Policies.” Journal of Machine Learning Research, 2016.

- Andrychowicz, M., et al. (OpenAI). “Learning Dexterous In-Hand Manipulation.” arXiv:1808.00177, 2018.

- Kumar, A., et al. (Google). “RoboMimic: Benchmarking Imitation Learning for Manipulation.” arXiv, 2021.

- Todorov, E., et al. “MuJoCo: A Physics Engine for Model-based Control.” IEEE IROS, 2012 (base para simulación robótica moderna).

Visión robótica y percepción

- Carion, N., et al. “DETR: End-to-End Object Detection with Transformers.” ECCV, 2020.

- Xiang, Y., et al. “PoseCNN: A Convolutional Neural Network for 6D Object Pose Estimation.” RA-L, 2017.

- Newcombe, R., et al. “Dense Tracking and Mapping in Real-Time.” ISMAR, 2011 (base para SLAM moderno).

IA multimodal y embodied AI

- Brohan, A., et al. (Google DeepMind). “RT-2: Vision-Language-Action Models.” arXiv:2307.15818, 2023.

- Ahn, M., et al. (Google). “Do As I Can, Not As I Say: Grounding Language in Robotic Affordances.” arXiv, 2022.

- Jang, E., et al. (Google). “BC-Z: Generalization in Robotic Manipulation via Behavior Cloning.” 2022.

- OpenAI. “GPT-4 Technical Report.” OpenAI Research, 2023 (base conceptual de modelos multimodales usados en Figure AI demos).

🔵 Documentación técnica oficial de robots humanoides

Documentos que sustentan especificaciones, capacidades y arquitecturas de los humanoides analizados.

Figure AI

- Figure AI. “Generalist Skill Learning for Humanoid Robots.” Technical Report & Public Demonstrations, 2023–2024.

- Figure 01 / Figure 03 Hardware Specifications. Figure AI Press Kit, 2024.

- Figure + OpenAI Collaboration Demo. Public Technical Demonstration, 2024.

Tesla Optimus

- Tesla, Inc. “Optimus Gen 1 & Gen 2 Demonstrations.” Tesla AI Day 2021, 2022, 2023, 2024.

- Tesla Robotics Team. “Optimus Actuator System Overview.” Internal Engineering Breakdown (publicly presented 2023).

Unitree G1

- Unitree Robotics. “G1 Humanoid Robot – Technical Specifications.” Product Sheet 2024.

- Unitree Robotics. Engineering videos y demostraciones técnicas 2023–2024.

Fourier GR-1

- Fourier Intelligence. “GR-1 General Purpose Humanoid Robot – Datasheet.” Technical Brief, 2024.

- Fourier Lab Demonstrations. Videos oficiales de locomoción y manipulación 2023–2024.

1X Technologies (Neo y EVE)

- 1X Technologies. “NEO: System Overview and Teleoperation Architecture.” 2023.

- 1X Eve Platform Documentation. Technical Notes 2022–2023.

- 1X Public Demonstrations. Teleoperation capabilities presentations.

🔵 Publicaciones de laboratorios líderes en robótica

MIT Biomimetic Robotics Lab

- Trabajos sobre actuadores de alta densidad, control de fuerza, locomoción dinámica y aprendizaje motor (2015–2023).

ETH Zürich – Robotic Systems Lab

- Publicaciones sobre ANYmal, control robusto de piernas, torque control y locomoción adaptativa (2017–2024).

UC Berkeley – Robot Learning Lab

- Investigación en aprendizaje por imitación, control motor basado en datos y robótica generalista (2019–2024).

Stanford Robotics & AI Lab

- Trabajos en manipulación con aprendizaje profundo y percepción 3D.

🔵 Recursos técnicos (frameworks, simuladores, estándares)

Simulación y modelado

- MuJoCo Physics Engine, Todorov et al., 2012–2023.

- Isaac Gym / Isaac Sim (NVIDIA): simulación acelerada para RL, 2021–2024.

Robotic Operating Systems

- ROS 2 Documentation. Open Robotics Foundation, 2020–2024.

- MoveIt 2 Manipulation Framework. Open Robotics, 2021–2024.

Modelos de movilidad y control

- MPC (Model Predictive Control) aplicado a robots de piernas, múltiples publicaciones ETH, CMU y MIT.

🔵 Material visual y demostraciones públicas (para imágenes referenciadas)

Estas fuentes respaldan el contenido de los image_groups usados en el blog.

Fuentes de imágenes oficiales

- Figure AI Press Images & Demos (Figure 01 y Figure 03).

- Tesla Bot / Optimus Media Materials (Tesla AI Day, demos 2023–2024).

- Unitree Robotics G1 Official Media Kit.

- Fourier Intelligence GR-1 Media Resources.

- 1X Technologies NEO/EVE Demo Footage & Press Kit.

🔵 Informes y análisis institucionales relevantes

- IEEE Spectrum Robotics. Cobertura técnica sobre Figure, Optimus y Unitree (2023–2025).

- Nature Robotics – Perspectives on Embodied AI (2022–2024).

- ACM Transactions on HRI: análisis de riesgos y desafíos de seguridad para robótica doméstica.

コメント