La robótica moderna está avanzando en el desarrollo de sistemas capaces de analizar su propio desempeño, detectar errores y ajustar su comportamiento con la mínima intervención humana. A este enfoque lo llamamos Self-Reflective Robotics o Self-Improving Robots: robots capaces de observar qué ocurrió, identificar la causa probable del fallo y generar una corrección razonada.

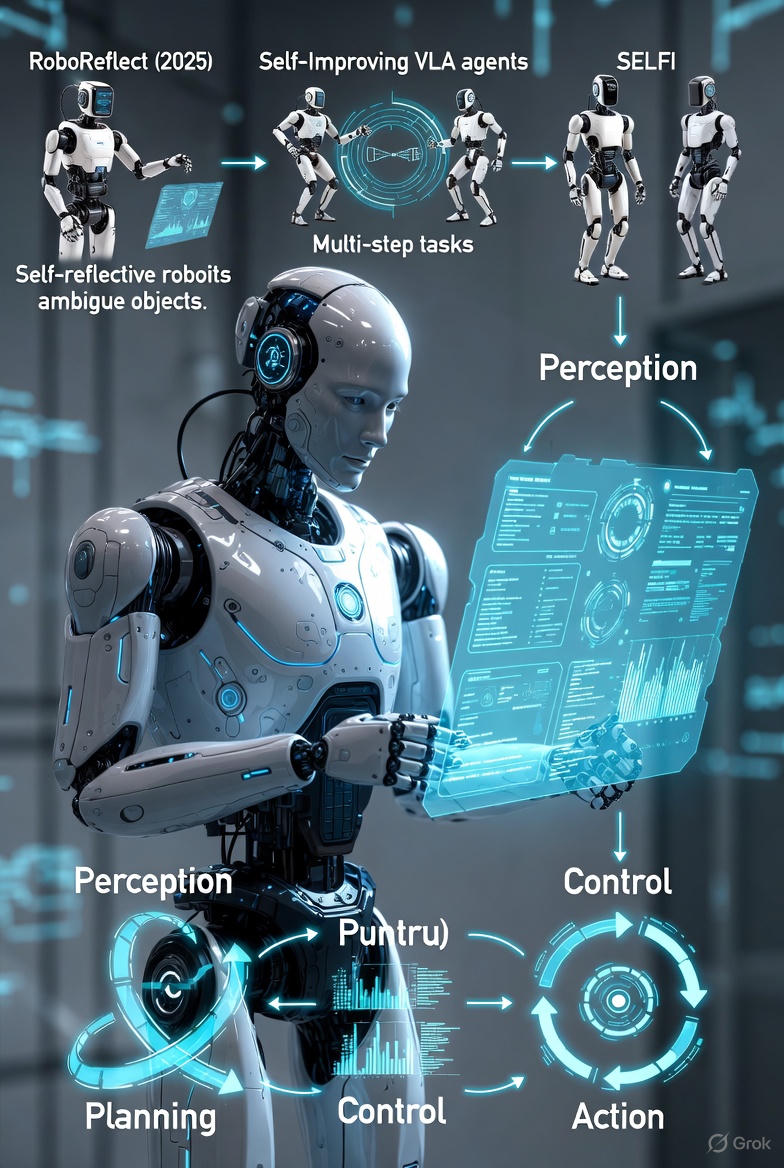

Varios trabajos recientes muestran resultados concretos en manipulación, navegación y modelos Vision-Language-Action (VLA), donde los agentes ya integran evaluación interna, auto-corrección y aprendizaje autónomo.

En este blog profundizamos en el fundamento técnico, los mecanismos utilizados y los resultados verificados en los papers que hoy forman esta nueva línea de trabajo en inteligencia física.

1. ¿Qué significa que un robot sea “self-reflective”?

Cuando un robot ejecuta una tarea, típicamente seguimos un ciclo clásico:

percepción → planificación → control → acción

Pero en un sistema self-reflective aparece un segundo ciclo, intercalado con el anterior, que analiza:

acción ejecutada → evaluación del resultado → reflexión sobre el error → generación de corrección

Este mecanismo permite que el robot:

- identifique fallos por su cuenta

- explique por qué falló (razonamiento causal)

- evalúe la calidad de la acción tomada

- genere nuevas estrategias más seguras o precisas

- acumule experiencias que podrá reutilizar

Esto ya no es “solo control”, ni “solo imitación”; es un paso hacia agentes físicos con capacidad de auto-evaluación, un componente básico de la agentic AI aplicada al mundo real.

2. Primer caso sólido: RoboReflect (2025)

Uno de los trabajos más completos hasta ahora es RoboReflect (2025), un marco que integra modelos visión-lenguaje (LVLMs) con un módulo de reflexión interna para manipulación en condiciones ambiguas.

Ref: Robotic Reflective Reasoning for Grasping Ambiguous-Condition Objects (2025, arXiv).

¿Qué aporta este trabajo?

RoboReflect introduce un ciclo donde el robot, tras ejecutar un agarre, analiza:

- si el agarre fue exitoso o no

- cómo quedó el objeto tras la acción

- la probabilidad de que el fallo se deba a:

- orientación errónea

- profundidad de agarre

- desalineación con el centro de masa

- colisión previa con el entorno

Si detecta un fallo, el agente genera una estrategia alternativa, basada en razonamiento espacial textual, y vuelve a intentarlo con una acción corregida.

Cuando finalmente lo logra, almacena la estrategia para futuras ejecuciones.

En pruebas reportadas en el paper, este proceso mejora significativamente la robustez cuando los métodos tradicionales fallan ante objetos ambiguos o parcialmente ocluidos.

3. Self-Improving VLA: reflexión para mejorar agentes visión-lenguaje-acción

Otro avance reciente es Reflection-Based Task Adaptation for Self-Improving VLA (2025), un trabajo que busca extender la auto-evaluación al campo de los modelos VLA modernos como RT-2, OpenVLA o Gemini Robotics.

Ref: Reflection-Based Task Adaptation for Self-Improving VLA (2025, arXiv).

Este enfoque propone dos mecanismos principales:

🔵 a) Failure-Driven Reflective RL

Cuando el robot se equivoca, un módulo analiza el fallo y genera una función de recompensa densa que describe:

- qué salió mal

- dónde ocurrió

- en qué instante sucedió la desviación

- qué acción hubiera sido más adecuada

Con esto, el robot puede mejorar la política sin necesidad de millones de episodios.

🔵 b) Success-Driven Quality-Guided SFT

Las trayectorias exitosas se filtran según una métrica de calidad y luego se usan para un self-fine-tuning estable, evitando el problema clásico de “reward hacking”.

Los resultados del paper muestran mejores tasas de convergencia y comportamientos más estables en tareas de manipulación que requieren precisión y adaptación.

4. Auto-mejora en robots móviles: el caso de navegación social

La auto-reflexión no es solo para manipuladores.

El marco SELFI (2024) aplica self-improvement mediante aprendizaje por refuerzo en robots móviles que deben navegar lugares públicos.

Ref: SELFI: Autonomous Self-Improvement with Reinforcement Learning for Social Navigation (2024, arXiv).

Los resultados muestran que el robot mejora en:

- evitar colisiones

- reaccionar ante peatones

- manejar obstáculos transparentes

- adaptarse a cambios en el entorno

- mantener velocidad segura en pasillos estrechos

Esto se logra mediante un ciclo continuo de:

ejecución → detección de error → ajuste de política → nueva ejecución

Sin necesidad de intervención humana constante.

5. ¿Cómo implementan realmente la reflexión los agentes modernos?

Los papers recientes revelan que la reflexión robótica no es un “módulo mágico”, sino una combinación de componentes bien definidos.

Los mecanismos más utilizados incluyen:

🔍 1. Evaluación del resultado

El robot compara la ejecución real con la planificación inicial.

Ejemplo: ¿la trayectoria se desvió?, ¿el objeto no quedó en la posición objetivo?

🧠 2. Análisis estructurado del error

Se usa visión multimodal o LVLM para interpretar causas:

- mala alineación

- rotación incorrecta

- colisión

- agarre insuficiente

📘 3. Generación de estrategias alternativas

El agente crea nuevas acciones basadas en sus interpretaciones.

En RoboReflect, esta etapa es generada por un modelo visión-lenguaje.

💾 4. Memoria interna

Las estrategias que funcionaron se guardan para uso futuro.

♻️ 5. Loop adaptativo

El robot repite el ciclo:

- intenta

- falla

- reflexiona

- ajusta

- ejecuta de nuevo

hasta alcanzar un resultado satisfactorio.

🛡️ 6. Control seguro

Antes de ejecutar una acción corregida, se aplica un chequeo de seguridad para evitar comportamientos peligrosos.

6. Ejemplos concretos de escenarios donde la auto-reflexión funciona bien

Según los resultados empíricos de las investigaciones:

✔ Manipulación de objetos ambiguos

RoboReflect mostró mejoras claras en agarres donde la geometría o la orientación no son evidentes.

✔ Tareas multi-paso con VLA

El trabajo de 2025 sobre Self-Improving VLA demostró mejoras especialmente en:

- ordenar objetos

- verter líquidos

- limpiar superficies

- organizar herramientas

✔ Navegación en entornos dinámicos

SELFI probó que los robots pueden aprender a navegar en espacios complejos sin nueva supervisión humana.

7. Limitaciones actuales: visión realista y científica

Aunque los avances son significativos, la auto-reflexión robótica enfrenta desafíos:

- Latencia y costo computacional:

Modelos como LVLM o VLA requieren hardware potente, lo cual dificulta la reflexión en tiempo real sin chips especializados. - Generalización limitada:

Una estrategia corregida funciona bien en un caso, pero no necesariamente en otro. - Riesgos de seguridad:

Una corrección mal evaluada podría producir comportamientos inseguros, especialmente con robots de fuerza elevada. - Interpretabilidad:

A veces resulta difícil saber por qué el módulo de reflexión sugiere un ajuste particular.

Los mejores trabajos recientes integran mecanismos de verificación y filtrado para mitigar estos riesgos.

8. Hacia una IA física más competente: impacto científico

Lo valioso de los self-reflective robots no es que “aprendan solos”, sino que aprenden a mejorar basándose en su propio desempeño, con mecanismos explícitos que la comunidad científica puede analizar y evaluar.

Esto permite:

- reducir necesidad de reprogramación

- disminuir los requerimientos de datos humanos

- mejorar adaptabilidad en entornos no estructurados

- desarrollar políticas más robustas sin entrenamiento masivo

- combinar razonamiento multimodal y control físico

Estos enfoques son especialmente relevantes para aplicaciones industriales de alta variabilidad, manejo de herramientas, tareas domésticas y navegación social.

📚 Referencias

RoboReflect (2025)

Robotic Reflective Reasoning for Grasping Ambiguous-Condition Objects

arXiv: https://arxiv.org/html/2501.09307v1

Self-Improving VLA (2025)

Reflection-Based Task Adaptation for Self-Improving VLA

arXiv: https://arxiv.org/abs/2510.12710

SELFI (2024)

Autonomous Self-Improvement with Reinforcement Learning for Social Navigation

arXiv: https://arxiv.org/abs/2403.00991

Robotics & self-modeling research (2023–2024)

Understanding the sense of self through robotics

White Rose Research Archive

https://eprints.whiterose.ac.uk/id/eprint/219433/1

コメント