Este blog está enfocado a robótica, control y GenAI aplicada

Introducción

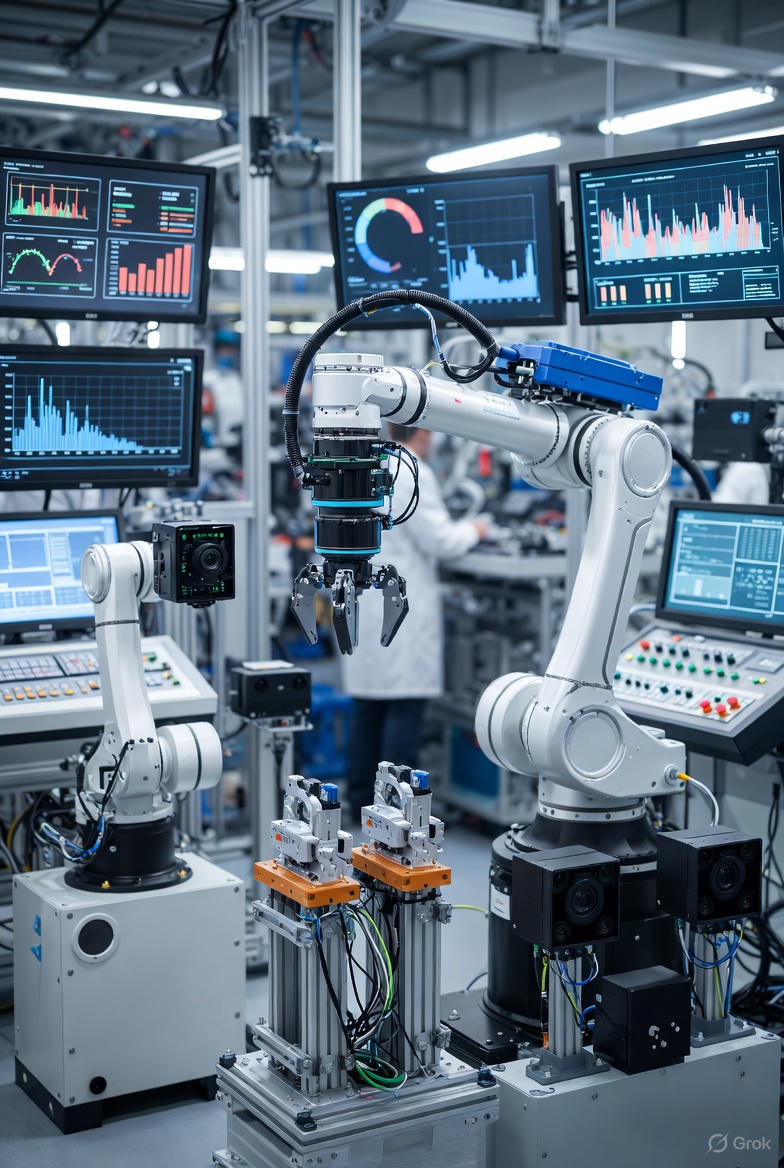

La irrupción de los modelos de lenguaje de gran escala (LLMs) en la ingeniería de control marca un cambio de paradigma que va mucho más allá de generar texto o asistir a programadores. Los nuevos agentes cognitivos basados en LLM se están integrando como capas superiores de supervisión, ajuste y planificación sobre sistemas de control clásicos —desde servoing y control PID, hasta arquitecturas avanzadas como MPC—, habilitando capacidades que antes requerían operadores humanos altamente especializados. Estos agentes pueden interpretar estados complejos, evaluar condiciones de seguridad, reconfigurar parámetros, razonar sobre objetivos multidimensionales y, de manera crucial, auto-reflexionar para corregir errores y mejorar su estrategia.

En investigación robótica, automatización industrial y control inteligente, emergen prototipos donde los agentes LLM combinan razonamiento simbólico, percepción multimodal y herramientas de software para controlar procesos, validar acciones mediante bucles de reflexión, interactuar con gemelos digitales e incluso participar en la reconfiguración continua de controladores predictivos. Esta tendencia está dando forma a lo que muchos ya denominan Agentic Control Systems: sistemas híbridos donde el control clásico garantiza estabilidad y seguridad en tiempo real, mientras que los agentes cognitivos aportan adaptabilidad, toma de decisiones explicables y capacidad de optimización de alto nivel.

En este escenario, frameworks como CrewAI, LangGraph y AgentKit se posicionan como piezas fundamentales para orquestar agentes, modelar ciclos cognitivos, integrar evaluadores y asegurar gobernanza. Y al mismo tiempo, surgen nuevas oportunidades para arquitecturas propias —como el enfoque NextFusion— que combinan planificación cognitiva, self-reflection estructurado y verificación automática para construir Agentes Cognitivos de Control aptos para aplicaciones industriales y robóticas avanzadas.

Este artículo profundiza en los fundamentos técnicos, las arquitecturas emergentes y la evidencia científica detrás de este nuevo campo, evaluando críticamente su potencial, sus límites y los retos necesarios para llevar estos sistemas a producción con garantías.

- 1. De los “chatbots” a los sistemas de control cognitivo

- 2. Breve recordatorio: servoing, MPC y dónde entra el LLM

- 3. Self-reflection: de técnica de prompting a mecanismo de estabilidad

- 4. Agentes + MPC + servoing: patrones de arquitectura

- 5. Comparación de frameworks: CrewAI vs LangGraph vs AgentKit

- 6. Riesgos y retos de los Agentic Control Systems

- 7. Conclusión

- Referencias

1. De los “chatbots” a los sistemas de control cognitivo

Los LLM ademas de ser grandes generadores de texto, hoy ya existen prototipos donde el modelo:

- Observa sensores y logs.

- Ajusta parámetros de control (PID, MPC, umbrales).

- Verifica condiciones de seguridad.

- Se autoevalúa y corrige su propia estrategia.

En robótica y automatización industrial ya se han publicado sistemas donde agentes basados en LLM planifican tareas, observan el entorno y ajustan el control de robots o servomecanismos en tiempo (casi) real.(arxiv.org)

A este paradigma lo podemos llamar Control Cognitivo impulsado por agentes LLM o Agentic Control Systems:

una capa cognitiva (LLM + agentes + herramientas) que se sienta por encima de los lazos de control clásicos para planificar, supervisar, ajustar y explicar el comportamiento del sistema.

2. Breve recordatorio: servoing, MPC y dónde entra el LLM

En control clásico podemos simplificar la arquitectura así:

- Lazo interno de servo / PID:

- Frecuencia alta (kHz–ms).

- Acciona directamente actuadores (motores, válvulas, etc.).

- Su objetivo es seguir referencias de posición, velocidad, torque, etc.

- Lazo de control avanzado (MPC – Model Predictive Control):

- Resuelve un problema de optimización sobre un horizonte finito.

- Respeta restricciones (saturaciones, seguridad, calidad de servicio).

- Se ha usado crecientemente en procesos industriales complejos.(sciencedirect.com)

- Nueva capa cognitiva (agente LLM):

- Recibe resúmenes de estados, alarmas, KPIs.

- Reformula objetivos, cambia “setpoints”, ajusta pesos del costo de MPC o ganancia de PID, agenda procedimientos de mantenimiento.

- Usa lenguaje natural para interactuar con operadores y otros servicios.

Trabajos recientes de LLMPC / Language Model Predictive Control muestran que un LLM puede verse como un optimizador implícito de funciones de costo, capaz de planificar de forma receding-horizon a partir de prompts que incluyen estado, objetivos y restricciones.(mdpi.com)

Esto da pie a que el LLM no sea el controlador directo, sino el planificador / supervisor que:

- Formula el problema de control (qué optimizar, bajo qué restricciones).

- Ajusta los parámetros de un MPC o un PID.(mdpi.com)

- Evalúa resultados y re-plantea el problema cuando cambian las condiciones.

3. Self-reflection: de técnica de prompting a mecanismo de estabilidad

3.1. ¿Qué es self-reflection en agentes LLM?

En la literatura de agentes LLM, self-reflection es un patrón donde el agente:

- Produce una respuesta o plan.

- Genera una reflexión crítica sobre lo que hizo (errores posibles, inconsistencias, riesgos).

- Usa esa reflexión para reintentar, corregir o mejorar el plan.

Experimentos sistemáticos muestran que agentes con self-reflection mejoran significativamente su rendimiento en tareas de razonamiento, planificación y resolución de problemas.(arxiv.org)

En entornos multi-agente, se han propuesto arquitecturas como COPPER, donde existe un reflector compartido que evalúa las contribuciones de cada agente y ajusta sus prompts/políticas para estabilizar la colaboración.(papers.nips.cc)

3.2. Self-reflection como “meta-control”

Si lo miramos con lentes de ingeniería de control:

- El controlador base (PID/MPC) regula la planta.

- El agente LLM genera planes, cambia objetivos, reconfigura parámetros.

- El módulo de self-reflection actúa como un meta-controlador:

- Monitorea desempeño (errores sostenidos, overshoot, oscilaciones).

- Detecta inconsistencias entre predicciones del agente y realidad.

- Aplica reglas del tipo:

- “Si tres iteraciones seguidas empeoran el KPI → revertir configuración y reducir amplitud de cambios”.

- “Si se viola una restricción de seguridad → congelar cambios y escalar a humano”.

No tenemos aún una teoría cerrada tipo Lyapunov para self-reflection en LLMs, pero la metáfora es clara:

el módulo reflexivo actúa como criterio de estabilidad cognitiva, limitando la exploración del agente y forzando convergencia hacia políticas que respetan invariantes de seguridad.

En la práctica, esto se implementa combinando:

- Evaluadores automáticos (scripts deterministas que verifican hard constraints).(mdpi.com)

- Revisión del propio LLM (critiques, chain-of-thought verificado).(arxiv.org)

- Human-in-the-loop en etapas críticas (aprobación de cambios de política, despliegues permanentes).

4. Agentes + MPC + servoing: patrones de arquitectura

4.1. Lazo interno: servo clásico

- Implementado en firmware, PLC o controladores dedicados.

- No se toca directamente desde el LLM.

- Garantiza estabilidad rápida ante perturbaciones locales.

4.2. Lazo medio: MPC / control avanzado

- Se ejecuta cada Δt en el orden de decenas o cientos de milisegundos (según la planta).

- Decide referencias para el lazo interno (por ejemplo, trayectoria de posición).

- Puede estar implementado en C/C++ o Python optimizado, con solver QP/MIQP.

En trabajos recientes, se han acoplado modelos multimodales (visión + LLM) para mejorar la percepción del estado sobre el que razona el controlador predictivo, por ejemplo en conducción autónoma con VLM-MPC.(i-newcar.com)

4.3. Lazo externo: agente cognitivo

Rol del agente LLM:

- Reformular el costo del MPC (pesos entre consumo, calidad, seguridad, confort).(mdpi.com)

- Ajustar setpoints y límites del PID (ej. sintonía adaptativa supervisada).(mdpi.com)

- Diseñar secuencias de alto nivel: start-up, shutdown, cambio de receta, reconfiguración ante fallo.

Ejemplos concretos en la literatura:

- Control robótico industrial multimodal (voz + visión), donde el operador se comunica con un agente LLM que traduce instrucciones en acciones de bajo nivel.(sciencedirect.com)

- Sistemas robóticos basados en LLM con arquitectura de doble agente (planner + executor) que observan el entorno, ajustan planes y corrigen en función de feedback.(arxiv.org)

En todos estos casos, el patrón es similar:

la planta nunca queda “a merced” directa del LLM; el LLM gobierna los parámetros y objetivos de controladores clásicos que sí tienen garantías de estabilidad.

5. Comparación de frameworks: CrewAI vs LangGraph vs AgentKit

Para llevar estos sistemas a producción se necesita orquestación fiable de agentes: estado, memoria, herramientas, observabilidad y guardrails. Veamos tres opciones populares.

5.1. CrewAI

- Paradigma: framework Python de multi-agente colaborativo.(docs.crewai.com)

- Fortalezas relevantes para control:

- Fácil definición de roles (Planner, Control-Tuner, Safety-Checker, Operator-Liaison).

- Soporta delegación de tareas y colaboración tipo “equipo de expertos”.

- Tiene memoria integrada y herramientas customizables (por ejemplo, endpoints hacia PLCs, SCADA, simuladores).

- Limitaciones para control estricto:

- El foco principal es automatización de flujos cognitivos, no control hard-real-time.

- El modelado explícito de estados y transiciones es más implícito que en LangGraph.

5.2. LangGraph

- Paradigma: orquestación basada en grafos de estado; nodos = funciones o LLMs, aristas = reglas de transición.(docs.langchain.com)

- Fortalezas:

- Excelente para flujos looping, condicionales y de larga duración, con persistencia de estado.

- Mensajería explícita entre nodos, checkpoints y recuperación.

- Encaja bien con la idea de self-reflection como nodo separado (critic / evaluator) en el grafo.

- En control cognitivo:

- Ideal para modelar el “cerebro” del sistema:

- Nodo de Perception → Planner → Control-Tuner → Evaluator → bucle.

- Permite separar claramente caminos nominales y rutas de fallo / degradación.

- Ideal para modelar el “cerebro” del sistema:

5.3. AgentKit (ecosistema OpenAI)

- OpenAI lanzó AgentKit como un toolkit completo para diseñar, desplegar y optimizar agentes, con constructor visual, conectores y pipelines de evaluación integrados.(platform.openai.com)

- Fortalezas:

- Integración nativa con modelos OpenAI, herramientas (tools), memoria y telemetría.

- Canvas visual para construir workflows, útil para alinear a equipos de ingeniería/operación.

- Pipelines de evals y optimización que encajan bien con la idea de self-evaluation continua.

- Nota: también existe un AgentKit de Inngest (TypeScript) con propósito similar de orquestación de agentes, pero con un foco más fuerte en integración serverless/event-driven.(agentkit.inngest.com)

5.4. Resumen comparativo

| Criterio | CrewAI | LangGraph | AgentKit (OpenAI) |

|---|---|---|---|

| Paradigma | Multi-agente colaborativo | Grafo de estado / orquestación de nodos | Toolkit integral para agentes + UI |

| Modelado de estado | Implícito (memoria, contexto) | Explícito (state object + edges) | Asociado a workflows y herramientas |

| Self-reflection | Patrón a nivel de agente | Nodo(s) dedicados de evaluación y crítica | Integrado vía evaluaciones y guardrails |

| Integración control en planta | Via tools hacia APIs / PLCs | Nodos que llaman servicios de control | Tools + conectores enterprise |

| Idoneidad p/control cognitivo | Buena para prototipos multi-rol | Muy buena para pipelines cognitivos robustos | Muy buena para despliegue enterprise |

Para un Agente Cognitivo de Control, una estrategia razonable sería:

- Usar LangGraph para el núcleo de orquestación del ciclo cognitivo (percepción-planificación-evaluación).

- Combinarlo con AgentKit o herramientas similares para despliegue, observabilidad y gestión de versiones en un contexto enterprise.

- Usar ideas de CrewAI cuando se requiera un equipo de agentes especializados (planner, tuner, auditor de seguridad, etc.).

6. Riesgos y retos de los Agentic Control Systems

- Latencia y determinismo

- LLMs son lentos comparados con lazos de control clásicos.

- Deben permanecer en capas de supervisión, nunca en lazo de control hard-real-time.

- Verificación y certificación

- Los controladores clásicos permiten análisis formal (estabilidad, robustez).

- Los agentes LLM introducen componentes no deterministas difíciles de certificar.

- En la práctica, se tiende a encapsular el LLM dentro de límites operativos estrictos.

- Shift de datos / drift de modelo

- La planta puede evolucionar (desgaste, cambios físicos).

- El modelo LLM puede actualizarse en la nube; hay que revalidar estrategias tras updates.

- Seguridad y alineamiento

- El agente puede “optimizar” métricas equivocadas si la función de costo no está bien diseñada.(mdpi.com)

- Las reglas de self-reflection deben incorporar explícitamente las restricciones de seguridad y compliance.

- Dependencia de infraestructura

- Integrar frameworks como LangGraph, CrewAI, AgentKit y sistemas industriales exige ingeniería de software y OT/IT madura.

7. Conclusión

El Control Cognitivo impulsado por agentes LLM no sustituye al control clásico; lo reconfigura y adapta a nuevas modalidades incrementando su potencialidad:

- Los lazos PID/MPC siguen siendo el “músculo” del sistema.

- El agente LLM aporta cognición: entiende objetivos de alto nivel, explora alternativas, se autoevalúa y ajusta estrategias.

- Frameworks como CrewAI, LangGraph y AgentKit proporcionan las piezas para construir agentes con memoria, herramientas, orquestación y guardrails en producción.(docs.crewai.com)

Es, en esencia, llevar la ingeniería de control a un siguiente nivel, añadiendo una capa de razonamiento explicable sobre los lazos clásicos, sin sacrificar las garantías que han hecho fiable a la automatización industrial durante décadas.

Referencias

- Maher, G., et al. (2025). LLMPC: Large Language Model Predictive Control. Computers, 14(3), 104.(mdpi.com)

- DeepMind. (2024). Learning to Learn Faster from Human Feedback with Language Model Predictive Control (LMPC).(Google DeepMind)

- Arif, T. M., et al. (2025). Agentic AI for Real-Time Adaptive PID Control of a Servo System. Actuators, 14(9), 459.(mdpi.com)

- Park, T. H., et al. (2025). LA-RCS: LLM-Agent Based Robot Control System. Sensors.(arxiv.org)

- Kadri, I., et al. (2025). LLM-driven agent for speech-enabled control of industrial robots.(sciencedirect.com)

- Zhang, Z., et al. (2025). Large language model driven multiple operating conditions MPC.(sciencedirect.com)

- Long, K., et al. (2024). VLM-MPC: Vision-Language Model Augmented Model Predictive Control.(i-newcar.com)

- Renze, M., & Guu, K. (2024). Self-Reflection in LLM Agents: Effects on Problem-Solving and Robustness.(arxiv.org)

- Gupta, P., et al. (2024). Learning Instructions for Language Agents using Past Failures and Self-Reflections. EMNLP.(aclanthology.org)

- Bo, X., et al. (2024). Reflective Multi-Agent Collaboration based on Large Language Models (COPPER). NeurIPS.(papers.nips.cc)

- GT-RIPL. Awesome LLM-Robotics. GitHub.(GitHub)

- CrewAI Documentation. What is CrewAI?; Crafting Effective Agents; Customize Agents.(docs.crewai.com)

- LangChain. LangGraph Overview; Graph API; LangGraph Reference.(docs.langchain.com)

- OpenAI. Agents – OpenAI Platform Docs; Introducing AgentKit.(platform.openai.com)

- Inngest. AgentKit – A TypeScript library to create and orchestrate AI agents.(agentkit.inngest.com)

コメント