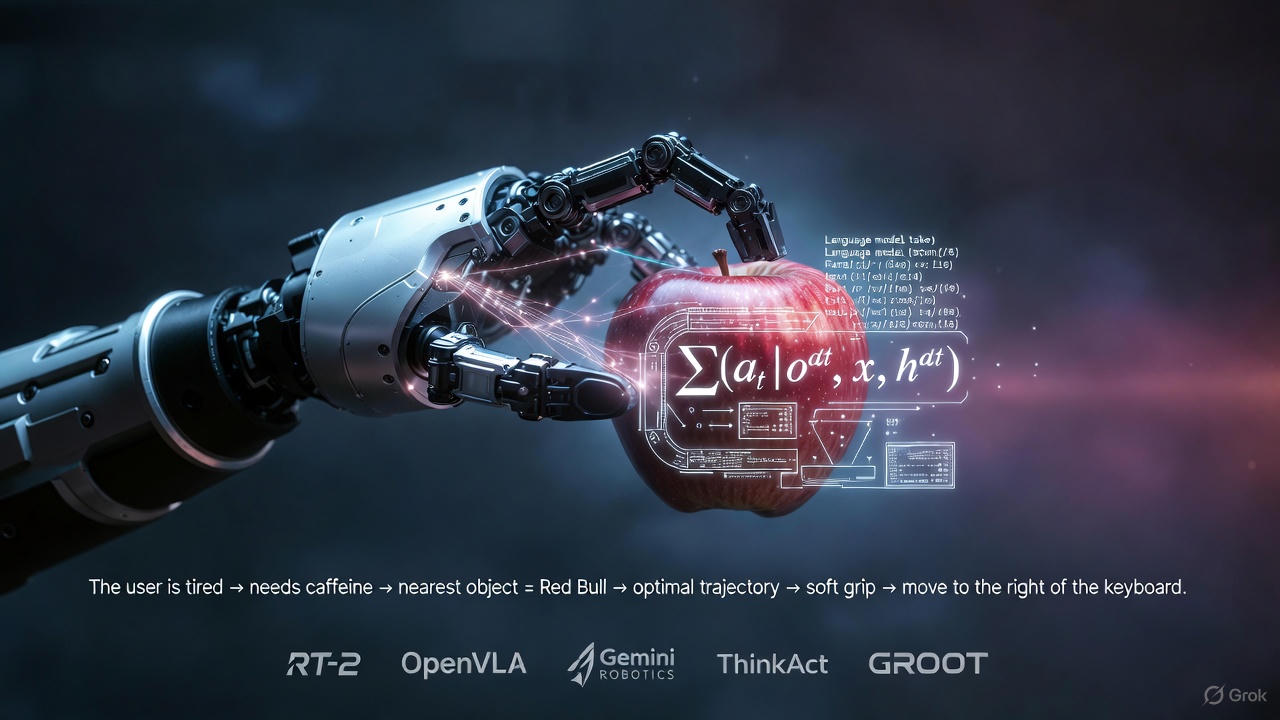

En los últimos dos años, la robótica ha entrado en una nueva etapa marcada por la aparición de los Modelos Vision-Language-Action (VLA), sistemas capaces no sólo de interpretar imágenes y lenguaje, sino de razonar y ejecutar acciones físicas en tiempo real. Desde los avances de Gemini Robotics hasta los modelos como OpenVLA, pasando por generalistas entrenados a escala como RT-2/RT-X y enfoques de razonamiento reforzado como ThinkAct, el campo está convergiendo hacia agentes físicos cada vez más inteligentes, adaptables y autónomos. En este blog analizaremos de forma crítica y técnica cómo funcionan estos modelos, qué los diferencia de los VLM tradicionales, y por qué la combinación de visión, lenguaje, acción y modelos de mundo está definiendo la próxima generación de robótica basada en IA.

- 1. De VLM a VLA: por qué esto es distinto

- 2. RT-2, RT-X y la transición a políticas generalistas

- 3. OpenVLA: el VLA abierto que alcanza y supera a los cerrados

- 4. Gemini Robotics: VLAs de propósito general sobre Gemini 2.0

- 5. ThinkAct (NVIDIA): “pensar antes de actuar” con plan latente visual

- 6. World Model + policy fusion: cerrar el bucle con RL “imaginado”

- 7. Tendencias transversales en VLAs de próxima generación

- 8. ¿Cómo aplicar esto en un stack robótico hoy?

- 9. Conclusión

- Referencias (selección)

1. De VLM a VLA: por qué esto es distinto

Los modelos vision-language-action (VLA) son la siguiente capa sobre los VLM/MuLM clásicos: no sólo describen el mundo, sino que deciden y ejecutan acciones físicas en él.

Formalmente, un VLA implementa una políticaπ(at∣o≤t,x,h≤t)

que toma observaciones visuales ot (imágenes, vídeo), una instrucción en lenguaje natural x y el historial ht, y produce una acción robótica at (poses del brazo, comandos de locomoción, etc.) a frecuencias de control compatibles con la realidad física.

En la práctica, casi todos los VLA modernos siguen el patrón:

- Backbone multimodal (VLM/MLLM pre-entrenado).

- Cabeza de acción que:

- Entrenamiento por imitación en grandes datasets de demostraciones robóticas, a menudo combinadas con datos web (imagen-texto, vídeo-texto). arXiv+1

El salto “próxima generación” viene de tres tendencias:

- Pre-entrenamiento multi-robot (X-embodiment) → RT-X, OpenVLA, GR00T N1. arXiv+2arXiv+2

- Razonamiento explícito antes de actuar → Gemini Robotics-ER, ThinkAct, VLA-R1. arXiv+2arXiv+2

- Post-training con modelos de mundo → WMPO, World-Env, VLA-RFT, World4RL. arXiv+3Hugging Face+3arXiv+3

Y todo ello bajo una restricción clave para robótica: lazo cerrado en tiempo (casi) real, típicamente unos pocos Hz de control continuo sobre hardware limitado.

2. RT-2, RT-X y la transición a políticas generalistas

2.1 RT-1: el baseline de control en tiempo real

RT-1 fue el primer “Robotics Transformer” a gran escala, entrenado con >130k demostraciones en 700+ tareas en robots móviles manipuladores. arXiv+1

Arquitectura clave:

- Encoder visual EfficientNet-B3 + FiLM.

- TokenLearner para comprimir tokens visuales relevantes.

- Transformer que recibe tokens de visión + lenguaje y produce tokens de acción discretos (11 dimensiones: 7 brazo, 3 base, 1 modo). arXiv+1

En inferencia, RT-1 ejecuta control cerrado a ~3 Hz, generando acciones hasta un token “terminate” o un límite de pasos. arXiv+1

Ese diseño (tokens discretos + compresión) define la latencia objetivo para casi todos los VLA posteriores.

2.2 RT-2: inyectar conocimiento web en la política

RT-2 (Robotics Transformer 2) responde a una pregunta concreta:

¿Podemos introducir directamente un VLM pre-entrenado en web y usarlo como política?

La receta de RT-2 es sorprendentemente simple:

- Se toma un VLM (entrenado en tareas como captioning y VQA).

- Se co-entrena en:

- tareas web de visión-lenguaje, y

- demostraciones robóticas,

expresando las acciones también como tokens de texto. arXiv+1

Resultados importantes:

- Emergent skills de razonamiento semántico: “coge el objeto más pequeño”, “coloca el objeto cerca del logo de X”, incluso cuando esas instrucciones no aparecen explícitamente en los datos robóticos. arXiv+1

- Capacidad de usar conocimiento web (ej. “bebida para alguien cansado”) para elegir un objeto apropiado. arXiv

Tiempo real: las demos de RT-2 mantienen el esquema de control por pasos estilo RT-1; la cadena de razonamiento puede generarse explícitamente como texto (“chain-of-thought”) y luego mapearse a acciones dentro del mismo modelo. robotics-transformer2.github.io

2.3 RT-X y RT-2-X: X-Embodiment a escala

Open X-Embodiment propone un dataset masivo:

- 22 robots distintos.

- 527 skills.

- 160,266 tareas y >1M episodios de demostración. arXiv+1

Sobre ese dataset se entrenan RT-1-X y RT-2-X: políticas generalistas X-robot que muestran positive transfer entre plataformas, mejorando la capacidad de robots individuales al compartir experiencia entre ellos. arXiv+1

Para VLAs de próxima generación, RT-2-X es importante por dos motivos:

- Demuestra que la misma arquitectura VLA puede escalar a múltiples robots sin re-entrenar desde cero por robot.

- Proporciona un baseline cerrado (RT-2-X 55B) que más tarde se usa como referencia en trabajos abiertos como OpenVLA. arXiv+1

3. OpenVLA: el VLA abierto que alcanza y supera a los cerrados

OpenVLA intenta contestar al problema de accesibilidad: casi todos los VLAs de referencia (RT-2, RT-2-X, Gemini Robotics) son cerrados.

3.1 Arquitectura

Según Kim et al. (2024): arXiv+1

- Backbone lingüístico: Llama-2 7B.

- Encoder visual: fusión de features pre-entrenadas de DINOv2 y SigLIP, lo que mejora la robustez visual.

- Entrenado sobre 970k episodios robóticos reales del ecosistema Open X-Embodiment.

- Cabeza de política que predice tokens de acción, similar a RT-2.

Es decir, conceptualmente es “RT-2-like pero abierto”, con un backbone distinto.

3.2 Rendimiento y ejemplos verificables

Resultados centrados en manipulación generalista:

- OpenVLA (7B) supera a RT-2-X (55B) en un +16,5% de éxito absoluto en 29 tareas y múltiples robots, a pesar de tener ~7× menos parámetros. arXiv

- En tareas de generalización semántica extrema (ej. “acerca la lata de Coca-Cola a Taylor Swift”), RT-2-X sigue ganando, porque conserva mejor el conocimiento de Internet. OpenVLA

EnEnEn despliegues reales (Google robots + Franka Panda): OpenVLA

- Tanto RT-2-X como OpenVLA resuelven tareas de manipulación típicas (mover objetos, colocarlos en recipientes, etc.) con alta fiabilidad.

- En fine-tuning para escenarios multi-objeto condicionados por lenguaje (ej. “Mueve el maíz amarillo al plato”), OpenVLA supera a Octo y a Diffusion Policy, gracias al pre-entrenamiento OpenX.

- En tareas ultra específicas de una sola instrucción, un policy especializado (Diffusion Policy) sigue siendo superior → trade-off entre generalidad y especialización.

3.3 Eficiencia de cómputo y “casi tiempo real”

Los autores muestran que OpenVLA puede: arXiv+1

- Fine-tunearse en GPUs de consumo usando LoRA/LoRA-like.

- Servirse con cuantización sin degradar significativamente las tasas de éxito.

No dan números de Hz, pero la combinación 7B + cuantización + compresión de tokens encaja en el régimen de control continuo a pocos Hz en una GPU moderna o plataformas edge potentes (Jetson Thor / AGX Thor, etc.), diseñadas precisamente para correr VLAs multi-modelo en el borde. TechRadar+1

4. Gemini Robotics: VLAs de propósito general sobre Gemini 2.0

Gemini Robotics es la respuesta de Google DeepMind al problema “¿cómo llevo un modelo tipo Gemini al mundo físico?”.

4.1 Arquitectura dual: Robotics-ER + Robotics 1.5

El informe técnico introduce dos componentes principales: arXiv+1

- Gemini Robotics-ER 1.5 (Embodied Reasoning)

- Extiende el razonamiento multimodal de Gemini 2.0 al dominio físico.

- Capacidades: detección de objetos, correspondencia multivista, predicción de trayectorias y agarres, cajas 3D, etc.

- Es, efectivamente, un VLM/MLLM embebido con fuerte entendimiento espacial-temporal.

- Gemini Robotics 1.5

- El VLA “puro”: convierte información visual + instrucciones en comandos motores.

- Ejecuta movimientos suaves y reactivos en un amplio rango de tareas de manipulación, robusto a variaciones de objetos, posiciones y entornos no vistos. arXiv+1

La clave de diseño de próxima generación es la separación explícita entre razonamiento y control, muy alineada con ThinkAct (más abajo).

4.2 Capacidades y ejemplos

El paper reporta que, con fine-tuning adicional, Gemini Robotics puede: arXiv+1

- Resolver tareas larga-horizonte y altamente dextrous (varios pasos, cambios de agarre, manipulación fina).

- Aprender nuevas tareas cortas a partir de ~100 demostraciones, lo que marca una mejora clara en eficiencia de datos frente a políticas entrenadas desde cero.

- Adaptarse a nuevas plataformas robóticas (embodiments distintos) reutilizando el mismo modelo.

El sitio oficial enfatiza que los modelos pueden descomponer metas en planes multi-paso y luego ejecutar esos pasos de forma autónoma, ampliando la noción de “agentic” (planificador + ejecutor en un solo stack). Google DeepMind

4.3 Gemini Robotics On-Device y tiempo real

Google también anuncia Gemini Robotics On-Device, una versión optimizada para correr localmente en el robot, manteniendo destreza y generalización pero con inferencia edge. Google DeepMind+1

Aunque no se publican cifras detalladas de latencia, la propia existencia de esta variante on-device indica:

- Compresión / distillation del backbone Gemini.

- Arquitectura pensada para lazo cerrado y comunicación de baja latencia con controladores de bajo nivel.

En la práctica, la visión que se perfila es:

- Robotics-ER razonando a baja frecuencia (planificación, tool-use, búsqueda en Google, etc.).

- Robotics 1.5 on-device ejecutando comandos motor a varios Hz, similar al régimen de RT-1/RT-2.

5. ThinkAct (NVIDIA): “pensar antes de actuar” con plan latente visual

ThinkAct es un framework VLA que hace explícito el principio de System 1 / System 2: un sistema lento que razona y uno rápido que ejecuta. NVIDIA+1

5.1 Arquitectura dual

Según Huang et al. (2025): arXiv+1

- Módulo de razonamiento (MLLM)

- BackBone: Qwen2.5-VL-7B.

- Entrada: observaciones visuales (trayectorias, vídeos) + instrucción.

- Salida:

- Chain-of-thought embebido (razonamiento textual),

- un plan latente visual compacto zplan, alineado con objetivos y consistencia de trayectoria vía reinforcement fine-tuning (GRPO) sobre recompensas de “acción-alineada”.

- Módulo de acción (policy)

- Policy DiT-based (Transformer de difusión) con ~432M parámetros.

- Entrenada inicialmente sobre Open X-Embodiment (OXE) para ejecutar acciones de bajo nivel.

- Durante la adaptación, se condiciona explícitamente en zplan vía un proyector tipo Q-Former para que el plan guíe la ejecución.

Importante: la arquitectura permite que razonamiento y acción operen asíncronamente: un plan latente puede abarcar múltiples pasos de control, lo que es ideal para tiempo real (el policy puede correr rápido, mientras el MLLM “piensa” a menor frecuencia). arXiv

5.2 Resultados cuantitativos

En benchmarks de manipulación:

- En SimplerEnv (Google-VM / Google-VA / Bridge-VM), ThinkAct supera a la policy base DiT-Policy en +11–17 puntos de éxito absoluto, alcanzando hasta 71,5% vs 56,0% en una de las configuraciones. arXiv

- En LIBERO (Spatial/Object/Goal/Long), ThinkAct logra el mejor éxito global (84,4%), por encima de CoT-VLA y otros baselines SOTA. arXiv

En benchmarks de razonamiento embebido (EgoPlan-Bench2, RoboVQA, OpenEQA), ThinkAct supera a GPT-4V, LLaVA-Video, InternVL, NVILA, etc., en métricas de precisión y BLEU, demostrando que el razonamiento reforzado mejora tanto comprensión como acción. arXiv+1

5.3 Implicaciones para tiempo real

Desde la perspectiva de control:

- El policy DiT puede ejecutarse a alta frecuencia, en la línea de los ~3 Hz de RT-1, dependiendo de hardware.

- El MLLM sólo necesita actualizar zplan cuando cambia la meta, el entorno o se detecta fallo → razonamiento amortizado, muy adecuado para robots con GPUs edge tipo Jetson Thor. TechRadar+1

En resumen, ThinkAct ilustra un patrón de diseño que veremos cada vez más:

MLLM (razonamiento reforzado) → plan latente compacto → policy eficiente → control en tiempo real.

6. World Model + policy fusion: cerrar el bucle con RL “imaginado”

Una limitación de muchos VLAs (RT-2, OpenVLA, Gemini Robotics) es que dependen casi exclusivamente de imitación de expertos:

– cuesta aprender de fallos,

– y refinar comportamientos sin más demostraciones humanas.

La nueva ola de trabajos introduce modelos de mundo generativos como “entornos virtuales” donde refinar políticas VLA vía RL, sin tocar el robot real.

6.1 WMPO: RL on-policy sobre VLA sin tocar el mundo real

WMPO (World-Model-based Policy Optimization) propone: arXiv+1

- Entrenar un modelo de mundo pixel-based que predice secuencias de frames, alineado con las features de un VLA pre-entrenado.

- Usar ese world model para realizar rollouts on-policy y aplicar GRPO (Group Relative Policy Optimization) directamente sobre la política VLA.

- Objetivos:

- Mejorar eficiencia de muestras.

- Permitir self-correction y aprendizaje continuo.

- Evitar costes y riesgos de interacción física.

Resultados: experimentos en simulación y robots reales muestran mejoras de rendimiento y emergent self-correction, manteniendo la política principal en forma VLA. arXiv+1

6.2 World-Env y VLA-RFT: simuladores basados en vídeo

World-Env plantea un framework de post-training donde: arXiv+2arXiv+2

- Se aprende un simulador de vídeo que genera observaciones futuras consistentes temporalmente.

- Un módulo VLM-basado proporciona recompensas continuas y decide terminación de acción.

- Así, se mejora el rendimiento con tan sólo 5 demostraciones por tarea en escenarios de manipulación compleja.

VLA-RFT, por su parte: arXiv+2GitHub+2

- Entrena un simulador de mundo a partir de datos reales e introduce una fase de reinforcement fine-tuning con recompensas verificables.

- Con <400 pasos de fine-tuning, supera baselines supervisados fuertes y mejora robustez bajo perturbaciones.

6.3 World4RL: diffusion world models para refinar policies

World4RL usa world models difusionales como simuladores de alta fidelidad para refinar políticas pre-entrenadas: arXiv+2arXiv+2

- Pre-entrena un modelo de mundo que captura dinámicas en multi-tarea.

- Refina la política completamente dentro del world model congelado, evitando interacción online con el mundo real.

- Diseña una codificación de acción “two-hot” para manipulación y usa backbones de difusión para mejorar fidelidad.

Experimentos muestran mejoras significativas de tasa de éxito respecto a imitación pura y otros baselines de RL.

6.4 Lección para VLAs en tiempo real

La conclusión común:

- Entrenas “lento” fuera de línea: world model pesado + RL sobre la política VLA.

- Ejecutas “rápido” en el robot: sólo la política refinada (VLA + quizá un pequeño critic) corre en tiempo real.

Este patrón es exactamente “world model + policy fusion”: fusionar la representación de mundo aprendida con la política VLA sin pagar el coste de simulación durante el control.

7. Tendencias transversales en VLAs de próxima generación

Basado en revisiones sistemáticas recientes de VLAs para robótica: arXiv+2VLA Models Survey+2

- Modularidad razonamiento/acción

- Gemini Robotics (Robotics-ER + 1.5), ThinkAct, VLA-R1 separan explícitamente razonamiento (CoT, planificación) de ejecución. arXiv+2arXiv+2

- Pre-entrenamiento X-embodiment y multi-dominio

- RT-X / Open X-Embodiment, OpenVLA, GR00T N1 (humanoides) unifican datos de muchos robots, simuladores y vídeos egocéntricos humanos. arXiv+2arXiv+2

- Razonamiento reforzado y CoT verificado

- ThinkAct, VLA-R1, VLA-RFT usan GRPO/RLVR y recompensas verificables para alinear el razonamiento con éxito de tarea, no sólo exactitud textual. arXiv+2arXiv+2

- Modelos de mundo como “entornos virtuales”

- WMPO, World-Env, World4RL, VLA-RFT: RL en simuladores aprendidos, con pixel-alignment o difusión, para mejorar sample-efficiency y seguridad. arXiv+3Hugging Face+3arXiv+3

- Optimización para tiempo real en el borde

- Compresión de tokens (TokenLearner, NVILA), modelos eficientes (7B, 8B) y hardware como Jetson Thor / AGX Thor optimizado para correr múltiples modelos generativos y VLAs al borde. robotics-transformer1.github.io+2openaccess.thecvf.com+2

- Plataformas integrales de “Physical AI”

- NVIDIA Cosmos, Isaac GR00T N1.x, Alpamayo-R1 para conducción autónoma: VLAs + world foundation models + simulación unificados. NVIDIA+2NVIDIA+2

8. ¿Cómo aplicar esto en un stack robótico hoy?

Para un equipo que quiera acercarse a estos VLAs de próxima generación con recursos razonables:

- Usar un VLA abierto como base de control

- OpenVLA es hoy la opción más madura y reproducible: código y checkpoints disponibles, soporte para múltiples robots y fine-tuning eficiente. arXiv+2GitHub+2

- Separar niveles de control

- Nivel alto: un MLLM generalista (Gemini, Qwen-VL, LLaVA-Video, etc.) que genere planes textuales o waypoints lógicos.

- Nivel bajo: VLA (OpenVLA, RT-1-X/RT-2-X cuando haya releases públicos) que traduzca esos planes a comandos motores.

- Incorporar modelos de mundo para post-training

- Entrenar un world model de vídeo / difusión sobre los logs del robot.

- Aplicar un framework tipo WMPO / World-Env / VLA-RFT para refinar la política sin gastar horas de robot. arXiv+3Hugging Face+3arXiv+3

- Diseñar para tiempo real desde el principio

- Estimar el presupuesto de latencia (ej. 100–300 ms por paso de control → 3–10 Hz).

- Ajustar tamaño del modelo (7B-ish con cuantización), pipeline de percepción (resoluciones moderadas, cropping inteligente) y colocación (edge GPU vs servidor).

- Elegir benchmarks y métricas

- Para comparación con la literatura, usar SimplerEnv, LIBERO, RoboVQA, EgoPlan-Bench2, etc., que ya son usados por ThinkAct y otros VLAs de referencia. arXiv+2arXiv+2

9. Conclusión

Los modelos VLA de próxima generación ya no son sólo “VLMs que devuelven acciones”:

- Gemini Robotics muestra cómo incrustar un modelo multimodal de escalas Gemini dentro de un stack robótico completo, con razonamiento embebido y policies adaptables a nuevos robots. arXiv+1

- RT-2/RT-X marcan la transición a políticas generalistas multi-robot basadas en conocimiento web y datasets X-embodiment. arXiv+2arXiv+2

- OpenVLA demuestra que un VLA abierto puede alcanzar e incluso superar modelos cerrados como RT-2-X en manipulación generalista, manteniendo una huella computacional compatible con tiempo real. arXiv+1

- ThinkAct cristaliza la separación razón-acción con visual plan latents, acercando un “System 2” reforzado a la práctica robótica. arXiv+1

- Y la familia de trabajos de world model + policy fusion (WMPO, World-Env, VLA-RFT, World4RL) apunta a un futuro donde robots aprenden principalmente en mundos imaginados, refinando políticas VLA que luego se ejecutan en tiempo real sobre hardware edge. arXiv+3Hugging Face+3arXiv+3

Para tu blog de robótica, IA y control, el mensaje central es claro:

la frontera ya no está en “ver y hablar”, sino en ver, razonar y actuar bajo restricciones físicas duras —latencia, seguridad, coste de datos—, y los VLAs de próxima generación están diseñados precisamente para ese régimen.

Referencias (selección)

- A. Brohan et al., “RT-2: Vision-Language-Action Models Transfer Web Knowledge to Robotic Control”, arXiv:2307.15818, 2023. arXiv+1

- Open X-Embodiment Collaboration, “Open X-Embodiment: Robotic Learning Datasets and RT-X Models”, arXiv:2310.08864, 2023. arXiv+1

- A. Brohan et al., “RT-1: Robotics Transformer for Real-World Control at Scale”, arXiv:2212.06817, 2022, y proyecto RT-1. arXiv+2robotics-transformer1.github.io+2

- M. J. Kim et al., “OpenVLA: An Open-Source Vision-Language-Action Model”, arXiv:2406.09246, 2024, y proyecto OpenVLA. arXiv+2OpenVLA+2

- Gemini Robotics Team, “Gemini Robotics: Bringing AI into the Physical World”, arXiv:2503.20020, 2025, y página oficial de Gemini Robotics (Google DeepMind). arXiv+2Google DeepMind+2

- J. Huang et al., “ThinkAct: Vision-Language-Action Reasoning via Reinforced Visual Latent Planning”, arXiv:2507.16815, 2025, y página del proyecto ThinkAct. arXiv+2NVIDIA+2

- F. Zhu et al., “WMPO: World Model-based Policy Optimization for Vision-Language-Action Models”, arXiv:2511.09515, 2025. arXiv+1

- J. Xiao et al., “World-Env: Leveraging World Model as a Virtual Environment for VLA Post-Training”, arXiv:2509.24948, 2025. arXiv+2arXiv+2

- H. Li et al., “VLA-RFT: Vision-Language-Action Reinforcement Fine-tuning with Verified Rewards in World Simulators”, arXiv:2510.00406, 2025. arXiv+2GitHub+2

- Z. Jiang et al., “World4RL: Diffusion World Models for Policy Refinement with Reinforcement Learning for Robotic Manipulation”, arXiv:2509.19080, 2025. arXiv+2arXiv+2

- A. Ye et al., “VLA-R1: Enhancing Reasoning in Vision-Language-Action Models”, arXiv:2510.01623, 2025. arXiv+2arXiv+2

- Z. Zhou et al., “ChatVLA: Unified Multimodal Understanding and Robot Control”, EMNLP 2025. aclanthology.org

- “Vision Language Action Models in Robotic Manipulation: A Systematic Review”, arXiv:2507.10672, 2025; y “Vision-Language-Action Models for Robotics: A Review Towards Real-World Applications”, 2025. arXiv+1

- NVIDIA, “NVIDIA Isaac GR00T N1: An Open Foundation Model for Humanoid Robots”, 2025. NVIDIA

- NVIDIA, “Jetson AGX Thor developer kit” y notas de prensa sobre Jetson Thor y GR00T N1.x para VLAs en el borde.

コメント