Dataset mixing, cross-embodiment learning y simulación masiva

Incluye: Open X-Embodiment, Diffusion Policies, RLHF físico, Trajectories + Language Alignment

- 1. De dataset multimodal al control físico: visión general

- 2. Dataset mixing y cross-embodiment: el rol de Open X-Embodiment

- 3. Diffusion Policies: políticas generativas para control continuo

- 4. RLHF físico: llevar la alineación al mundo real

- 5. Alineamiento de trayectorias y lenguaje

- 6. Simulación masiva: fabricar experiencia robótica a escala

- 7. Cómo se entrena un robot generalista: pipeline integrado

- 8. Aspectos críticos y retos abiertos

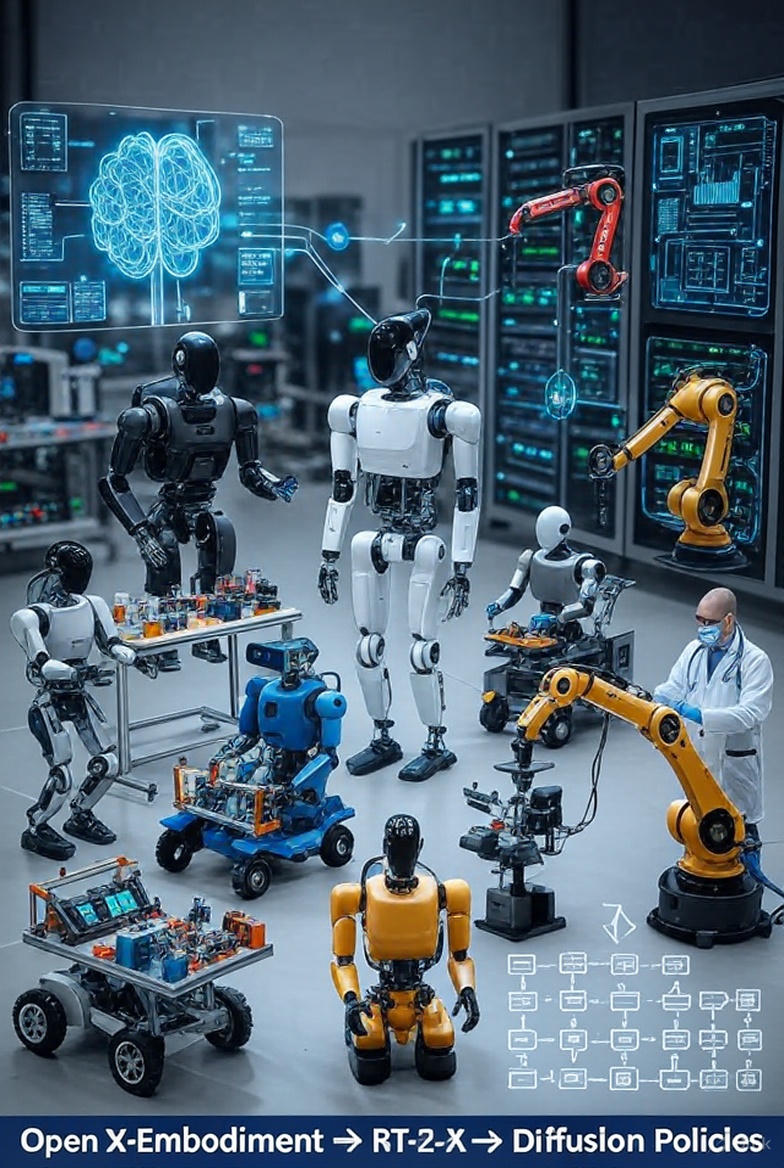

1. De dataset multimodal al control físico: visión general

El entrenamiento de robots generalistas ha evolucionado radicalmente en los últimos años. En lugar de sistemas diseñados para tareas específicas, hoy buscamos políticas generales capaces de operar en múltiples robots, entornos y condiciones físicas. Esto exige combinar modelos de visión y lenguaje a gran escala con datos robóticos multimodales y técnicas avanzadas de control. La idea central es construir un agente capaz de comprender el entorno, interpretar instrucciones humanas y ejecutar acciones físicas coherentes y seguras.

Este proceso suele comenzar con pretraining multimodal, continúa con mezcla de datasets robóticos, progresa hacia el aprendizaje de políticas generativas y se refina mediante RL en simulación masiva y retroalimentación humana en el mundo real. El objetivo final es entrenar una política única—o un pequeño conjunto de políticas—capaz de adaptarse a distintos cuerpos robóticos sin reentrenamiento exhaustivo.

2. Dataset mixing y cross-embodiment: el rol de Open X-Embodiment

Consolidar datos provenientes de múltiples robots, laboratorios y tareas representa uno de los desafíos más profundos del aprendizaje robótico moderno. La diversidad entre plataformas, sensores, cinemáticas y estilos de demostración puede generar inconsistencias que arruinan el entrenamiento. Precisamente por esto surge Open X-Embodiment, un esfuerzo comunitario que unifica más de un millón de trayectorias provenientes de 34 laboratorios y 22 tipos de robots distintos.

2.1. ¿Qué es Open X-Embodiment?

Open X-Embodiment propone un estándar común para almacenar y normalizar datos robóticos: observaciones, acciones, estados y metadatos de tarea. Este dataset masivo permite entrenar políticas cross-embodiment, es decir, modelos capaces de aprender comportamientos que se transfieren positivamente entre robots muy distintos.

2.2. Dataset mixing: cómo mezclar sin destruir la señal

Mezclar múltiples datasets exige técnicas específicas, como:

- Estándares comunes para representar acciones (por ejemplo, vectores de posición/orientación del efector final).

- Sampling estratificado para evitar que un robot o tarea domine el entrenamiento.

- Etiquetas explícitas de tarea y robot que ayudan al modelo a contextualizar la acción.

- Pérdidas multitarea que equilibran la contribución de los distintos conjuntos.

Estas estrategias permiten que un robot aprenda, por ejemplo, a manipular objetos aprovechando la experiencia adquirida por otro robot con distinta morfología.

2.3. Cross-embodiment learning en la práctica

El aprendizaje cross-embodiment permite que políticas como RT-1-X o RT-2-X transfieran conocimiento entre robots con diferentes grados de libertad. Estudios recientes muestran mejoras superiores al 50% en rendimiento respecto a modelos entrenados en datasets individuales. Este tipo de generalización emergente es el fundamento de los foundation models para robótica.

3. Diffusion Policies: políticas generativas para control continuo

El control robótico requiere manejar distribuciones complejas de acciones continuas, particularmente en tareas con múltiples soluciones posibles. Las Diffusion Policies abordan este problema modelando la política como un proceso generativo tipo difusión (similar a los modelos usados en la generación de imágenes). La política aprende a generar secuencias de acciones “denoising” desde ruido, condicionada por observaciones visuales y metas en lenguaje.

Este enfoque ofrece ventajas clave: maneja multimodalidad, evita el colapso en políticas deterministas y produce trayectorias estables incluso en tareas de alta complejidad.

3.1. ¿Qué es una Diffusion Policy?

En una Diffusion Policy, la acción futura se modela como una muestra de una distribución compleja. El modelo aprende a reconstruir una trayectoria correcta partiendo de ruido, lo que permite producir secuencias continuas ricas y variadas. Esta técnica ha superado métodos tradicionales de imitación en muchos benchmarks de manipulación.

3.2. Integración con lenguaje y VLMs

El control robótico basado en lenguaje requiere vincular instrucciones verbales con trayectorias físicas. Las Diffusion Policies pueden condicionarse con embeddings generados por modelos de visión-lenguaje (VLM), permitiendo que el robot interprete instrucciones ambiguas o de alto nivel y genere múltiples soluciones válidas.

3.3. Fine-tuning con RL: DPPO

Aunque originalmente imitativas, las Diffusion Policies pueden ajustarse mediante policy gradient, como muestra DPPO. Esto permite combinar lo mejor de dos mundos: la estabilidad de la imitación y la optimización fina de RL.

4. RLHF físico: llevar la alineación al mundo real

A diferencia de los modelos de lenguaje, los robots deben actuar en un entorno físico y compartir espacio con personas, lo que implica riesgos. El aprendizaje por refuerzo con retroalimentación humana (RLHF) permite incorporar preferencias humanas sobre el comportamiento del robot. Cuando esta retroalimentación se da físicamente, mediante intervenciones en tiempo real, hablamos de RLHF físico.

Esta aproximación es crítica para lograr robots que no solo ejecuten acciones válidas, sino también socialmente aceptables, seguras y alineadas con la intención humana.

4.1. RLHF clásico vs RLHF físico

RLHF tradicional utiliza juicios humanos (por ejemplo, comparaciones entre dos trayectorias) para entrenar un modelo de recompensa. En RLHF físico, la intervención humana—como detener al robot, corregirlo o empujarlo suavemente—se interpreta como señal de preferencia.

4.2. Aprender de feedback físico directo

Métodos como One-Shot Physical Adaptation muestran que un robot puede adaptarse rápidamente a nuevas condiciones gracias a intervenciones físicas que funcionan como correcciones directas al comportamiento.

4.3. RLHF + habilidades primitivas: SEED

El enfoque SEED combina descomposición de tareas en habilidades primitivas con feedback humano para guiar cómo esas habilidades se encadenan en tareas largas. Esto reduce la carga de demostraciones y facilita el aprendizaje de acciones complejas.

4.4. Human-in-the-loop RL para manipulación hábil

Investigaciones recientes demuestran que políticas de alta destreza pueden entrenarse en robots reales en apenas 1–2 horas usando bucles eficientes de RL con intervenciones humanas periódicas.

4.5. Feedback físico + preferencias semánticas

Modelos como RLPF combinan restricciones físicas, embebidas en simulación, con instrucciones textuales, logrando movimiento seguro y semánticamente alineado en humanoides.

5. Alineamiento de trayectorias y lenguaje

Para que un robot generalista comprenda y ejecute instrucciones en lenguaje natural, es fundamental alinear representaciones lingüísticas con secuencias de movimiento. Este es el núcleo de modelos como RT-2, RT-2-X y CLIP-RT, que combinan datos web (lenguaje + imágenes) con trayectorias robóticas etiquetadas.

5.1. RT-2 y RT-2-X: visión-lenguaje-acción

RT-2 integra datos de internet con datos de robots para producir una política capaz de interpretar instrucciones semánticas complejas. Su versión RT-2-X, entrenada sobre Open X-Embodiment, muestra generalización emergente entre robots y tareas no vistas.

5.2. CLIP-RT y ampliación lingüística

CLIP-RT utiliza modelos multimodales estilo CLIP para generar descripciones de trayectorias, ampliando masivamente los datos textuales asociados a las acciones. Esto permite entrenar políticas que entienden mejor matices lingüísticos.

5.3. Language-conditioned manipulation

Marcos recientes combinan LLMs para planificación de alto nivel con políticas de bajo nivel entrenadas en trayectorias, permitiendo descomponer instrucciones complejas en pasos realizables.

6. Simulación masiva: fabricar experiencia robótica a escala

Entrenar robots enteramente en el mundo real es lento, costoso y peligroso. Por eso, los motores de simulación masiva se han convertido en un pilar técnico esencial. Plataformas como Isaac Lab, Genesis y frameworks como Galactic permiten generar miles de millones de pasos de experiencia en cuestión de horas.

6.1. Isaac Gym / Isaac Lab

Estos frameworks ejecutan física, percepción y RL completamente en GPU, con miles de entornos paralelos. Se han mostrado capaces de entrenar habilidades como locomoción en minutos gracias a la paralelización extrema.

6.2. Genesis

Genesis lleva esta idea aún más lejos, alcanzando velocidades reportadas de más de 40 millones de pasos por segundo en una sola GPU. Esto permite generar años de experiencia sintética en una tarde.

6.3. Marcos de RL masivo: Galactic

El framework Galactic explora escalas de entrenamiento nunca vistas: billones de pasos y tasas superiores a 400.000 pasos por segundo. Esto habilita tareas complejas de rearrangement con altos niveles de generalización y robustez sim-to-real.

7. Cómo se entrena un robot generalista: pipeline integrado

A partir de todos los componentes anteriores, el pipeline moderno para entrenar un robot generalista se puede resumir así:

- Pretraining multimodal (visión + lenguaje).

- Construcción de un dataset robótico multimodal combinando Open X-Embodiment y simulación masiva.

- Entrenamiento de una política fundacional (VLA o Diffusion Policy).

- Cross-embodiment learning para generalizar entre robots.

- Fine-tuning con RL y RLHF físico.

- Alineamiento lenguaje-trayectorias continuo mediante co-entrenamiento.

- Despliegue con ciclo humano-en-el-lazo para correcciones y seguridad.

Este proceso es iterativo, expansivo y mejora conforme aumenta la diversidad de robots, entornos y tareas.

8. Aspectos críticos y retos abiertos

A pesar de los avances, persisten desafíos fundamentales:

- Sesgos en datasets: muchos robots, entornos industriales o aplicaciones médicas aún están subrepresentados.

- Sim-to-real gap: la física simulada sigue siendo imperfecta.

- Seguridad física: garantizar comportamientos seguros en todos los escenarios es un problema abierto.

- Evaluación de generalismo: no existe un benchmark estandarizado comparable al de modelos de lenguaje.

- Costo del dato físico: se prevé la necesidad de infraestructura global para teleoperación y recolección continua de datos reales.

Referencias

Brohan, A., et al. (2023). RT-2: Vision-Language-Action Models Transfer Web Knowledge to Robotic Control. arXiv:2307.15818.

Chi, C., et al. (2023). Diffusion Policy: Visuomotor Policy Learning via Action Diffusion. RSS.

Ren, A. Z., et al. (2024). DPPO: Diffusion Policy Policy Optimization. arXiv.

Open X-Embodiment Collaboration. (2023). Open X-Embodiment: Robotic Learning Datasets and RT-X Models. CoRL Workshop.

Hiranaka, A., et al. (2023). SEED: Primitive Skill-based Robot Learning from Human Feedback. arXiv:2307.15801.

Shek, A., et al. (2022). Learning from Physical Human Feedback: Object-Centric One-Shot Adaptation. CMU Robotics Institute.

Luo, J., et al. (2024). Human-in-the-Loop Reinforcement Learning for Dexterous Manipulation. arXiv.

Yue, J., et al. (2024). Reinforcement Learning from Physical Feedback (RLPF). OpenReview.

CLIP-RT Authors. (2025). CLIP-RT: Language-Conditioned Robotic Policies from Natural Language Supervision. arXiv.

NVIDIA. (2024–2025). Isaac Lab Technical Reports.

Genesis Team. (2024). Genesis: A Universal Physics Engine for Embodied AI. Project documentation.

Berges, V.-P., et al. (2023). Galactic: Scaling End-to-End RL for Rearrangement. arXiv.

コメント