- ¿Estamos cerca del robot general? Una mirada honesta

- Introducción

- 1. Qué ya funciona (y por qué es relevante)

- 2. Qué es marketing (o generalización prematura)

- 3. Qué falta realmente

- 4. Demo vs despliegue: una diferencia estructural

- 5. Hacia dónde va la investigación después de 2025

- Conclusión

- Listado de referencias

¿Estamos cerca del robot general? Una mirada honesta

Introducción

En 2025 el discurso sobre robótica cambió de forma sustancial. Durante más de una década, el foco estuvo puesto en la mejora incremental de manipuladores industriales, robots móviles y sistemas humanoides altamente especializados. Hoy, la conversación gira alrededor de un concepto más ambicioso: Physical AI, entendido como la integración de modelos fundacionales, percepción multimodal, políticas de control y cuerpos físicos capaces de operar en el mundo real con cierto grado de generalidad.

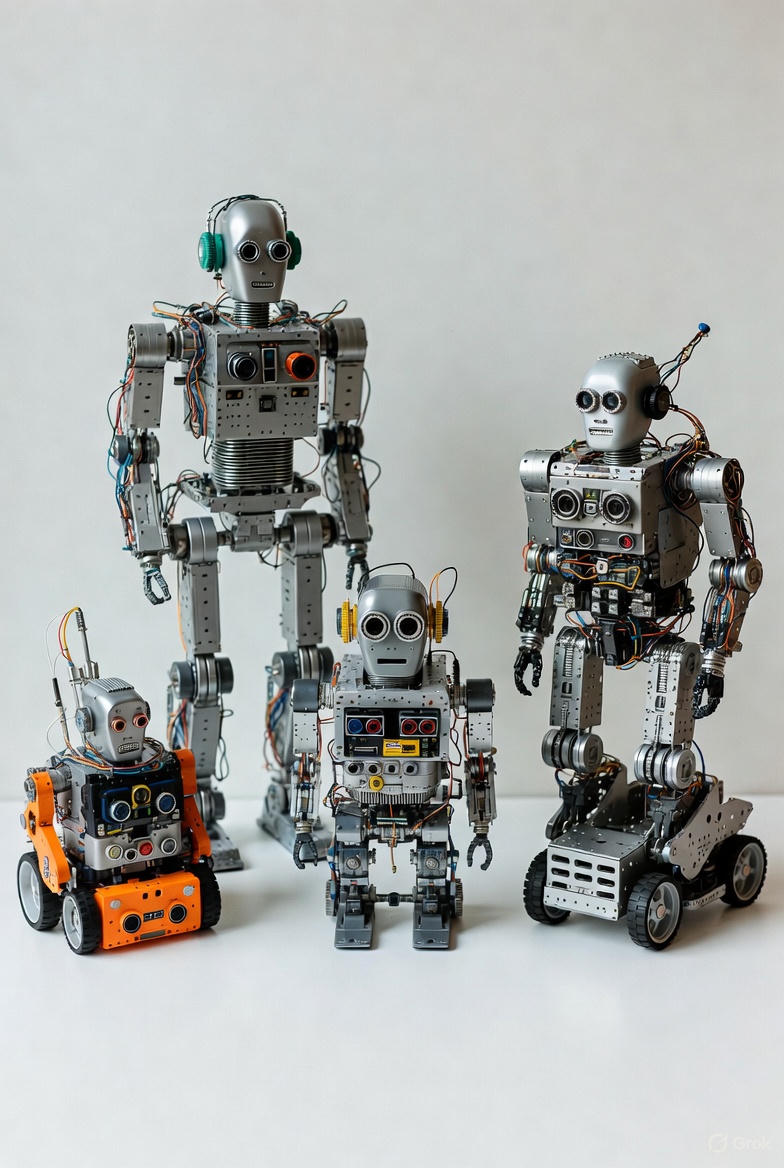

Sin embargo, este cambio narrativo también ha traído confusión. El término robot general se utiliza de forma laxa para describir desde demos espectaculares en laboratorios controlados hasta sistemas que apenas comienzan a operar en entornos productivos. Este artículo propone una evaluación rigurosa y crítica del estado del arte: qué funciona hoy, qué es principalmente marketing, qué barreras siguen abiertas y hacia dónde se dirige la investigación real a partir de 2025.

1. Qué ya funciona (y por qué es relevante)

1.1 Despliegues reales: menos glamour, más ingeniería

A diferencia de las demostraciones virales, los sistemas robóticos que efectivamente están operando en 2025 lo hacen bajo condiciones muy concretas. Un ejemplo sólido es el robot Stretch de Boston Dynamics, diseñado para la descarga automática de camiones. Su adopción por parte de DHL, con planes de escalar a más de mil unidades, es relevante no por la complejidad de la tarea, sino porque implica operación continua, integración con flujos logísticos existentes, mantenimiento, seguridad y retorno económico medible.

De forma similar, Digit de Agility Robotics comenzó a operar en instalaciones logísticas de GXO bajo un modelo Robotics-as-a-Service. Aquí el punto clave no es la morfología humanoide, sino la capacidad de ejecutar una tarea repetible con tolerancia a fallos, interacción segura con humanos y métricas operativas claras. Estos sistemas no son “generales”, pero sí son evidencia de que la robótica está cruzando la frontera entre laboratorio y producto.

1.2 El avance estructural: modelos Vision–Language–Action

El salto conceptual más importante de los últimos años no vino del hardware, sino del aprendizaje. Modelos como RT-2 demostraron que el conocimiento semántico adquirido a escala web puede transferirse parcialmente a control robótico cuando se integra en arquitecturas Vision–Language–Action (VLA). Esto permitió que un robot ejecute acciones razonables frente a instrucciones o escenarios no vistos explícitamente durante el entrenamiento.

Este enfoque se consolidó con iniciativas como Open X-Embodiment, que agregaron más de un millón de trayectorias robóticas reales provenientes de distintos laboratorios, plataformas y morfologías. El valor científico aquí no es solo el volumen de datos, sino la posibilidad de entrenar políticas que trascienden un cuerpo específico, un requisito fundamental para cualquier noción seria de generalidad física.

2. Qué es marketing (o generalización prematura)

2.1 La versión del demo

Una constante en la robótica contemporánea es la sobreinterpretación de demos cuidadosamente orquestadas. Videos de robots doblando ropa, cocinando u ordenando objetos suelen ocultar supuestos críticos: entornos altamente controlados, selección de tomas exitosas, intervención humana fuera de cámara o resets manuales frecuentes.

Desde una perspectiva técnica, una demostración carece de valor si no está acompañada de métricas como tasa de éxito, tiempo medio entre fallos, capacidad de recuperación autónoma y dependencia humana. La generalidad no se demuestra con una tarea bien ejecutada, sino con robustez frente a la variación y el error.

2.2 “Physical AI” como etiqueta ambigua

En 2025, Physical AI se ha convertido en un término paraguas. Para algunos actores, como NVIDIA, representa un stack completo que incluye simulación física, datos sintéticos y modelos fundacionales entrenados para control. Para otros, como el World Economic Forum, es un concepto macroeconómico ligado a la productividad industrial.

El problema surge cuando se utiliza el término sin especificar arquitectura, supuestos, latencia, consumo energético o evaluación. En esos casos, Physical AI deja de ser una categoría técnica y se transforma en marketing narrativo.

3. Qué falta realmente

3.1 Datos: la larga cola del mundo físico

Aunque datasets como Open X-Embodiment representan un avance sustancial, el mundo real sigue dominado por eventos raros: contactos inesperados, materiales deformables, fricción variable, superficies imperfectas o en mal estado, deterioro, líquidos, reflejos y desgaste. Estas condiciones forman distribuciones de cola larga que hoy están subrepresentadas en los datos disponibles.

Además, todavía no existe un consenso claro sobre benchmarks que correlacionen con el desempeño en producción, lo que dificulta evaluar el progreso real más allá del laboratorio.

3.2 Energía y autonomía

La generalidad física es energéticamente costosa. Sensores, cómputo onboard, actuadores y movilidad compiten por un presupuesto energético limitado. En humanoides, esto se traduce en autonomías reducidas o en compromisos severos de fuerza y velocidad. Sin avances significativos en densidad energética o eficiencia de cómputo, la generalidad seguirá siendo local y temporal.

3.3 El cuerpo importa tanto como el modelo

La robótica no es solo software. La falta de manos robustas, económicas y con sensado táctil rico sigue siendo un cuello de botella. A esto se suma la necesidad de compliance mecánica para manejar incertidumbre en el contacto y tolerancias que permitan operar sin recalibración constante. Ningún modelo fundacional compensa un cuerpo mal diseñado.

3.4 Cognición embodiment y seguridad

Modelos VLA pueden generar planes plausibles, pero todavía fallan en el control fino bajo condiciones fuera de distribución. Además, la seguridad física impone restricciones que no existen en modelos puramente digitales. Iniciativas como los benchmarks de seguridad robótica impulsados por DeepMind reflejan un reconocimiento explícito de este problema.

4. Demo vs despliegue: una diferencia estructural

Un despliegue real implica integración con sistemas existentes, entrenamiento de operadores, protocolos de seguridad, mantenimiento, repuestos y escalabilidad. Requiere también aceptar que el robot fallará y diseñar para la recuperación.

Por eso, los pocos casos que escalan, como logística, son tan relevantes: no porque resuelvan la robótica general, sino porque demuestran qué partes del problema ya son económicamente viables.

5. Hacia dónde va la investigación después de 2025

En 2025 se consolidó una dirección clara: modelos fundacionales robóticos combinados con simulación a gran escala y datos sintéticos, como en el caso de Isaac GR00T N1 de NVIDIA. En paralelo, propuestas como Helix de Figure AI muestran un énfasis creciente en ejecutar razonamiento y control de forma eficiente y onboard, señal de madurez técnica.

La tendencia apunta menos a “un robot que haga todo” y más a infraestructuras cognitivas transferibles entre cuerpos, tareas y dominios, con evaluación rigurosa y foco industrial.

Conclusión

No, el robot general aún no está aquí. Pero tampoco estamos en el punto inicial que muchos críticos sugieren. En 2025 la robótica entró en una fase más honesta: menos promesas universales, más sistemas parciales que funcionan y una comprensión mucho más clara de las barreras físicas, energéticas y cognitivas que aún existen.

El verdadero avance no es un humanoide espectacular, sino la convergencia entre modelos, datos, simulación y diseño de sistemas completos, seguros, más estables y actuando en entornos reales.

Listado de referencias

- Brohan, A. et al. RT-2: Vision-Language-Action Models Transfer Web Knowledge to Robotic Control. arXiv:2307.15818.

- Open X-Embodiment Collaboration. Open X-Embodiment: Robotic Learning Datasets and RT-X Models. arXiv / ICRA.

- Boston Dynamics. Stretch for Warehouse Automation (documentación y casos industriales).

- DHL Supply Chain. Automation at Scale with Boston Dynamics Stretch (press release + PDF técnico).

- Agility Robotics. Digit Deployed in Logistics Operations with GXO.

- NVIDIA. Isaac GR00T N1: Foundation Models for Humanoid Robots (whitepaper oficial).

- Figure AI. Helix: Vision-Language-Action Model for Humanoid Robots (technical overview).

- DeepMind. Robotics, Embodied Reasoning and Safety Benchmarks (Gemini Robotics, ASIMOV).

- Reuters. Investment surge in foundation models for robotics (Skild AI, 2025).

- World Economic Forum. Physical AI: Unlocking a New Era of Industrial Productivity (2025 report).

コメント